Il Parlamento e il Consiglio europeo hanno raggiunto un accordo provvisorio sulla legge sull’intelligenza artificiale. Questo regolamento mira a garantire che i diritti fondamentali, la democrazia, lo Stato di diritto e la sostenibilità ambientale siano protetti dai rischi derivanti dall’uso dell’IA, promuovendo al contempo l’innovazione e rendendo l’Europa leader nel settore.

Le norme stabiliscono obblighi per l’IA in base ai rischi potenziali e al livello di impatto. Vediamo i punti principali.

Applicazioni vietate

Riconoscendo la potenziale minaccia ai diritti dei cittadini e alla democrazia rappresentata da alcune applicazioni dell’IA, si è convenuto di vietare:

- sistemi di categorizzazione biometrica che utilizzano caratteristiche sensibili (convinzioni politiche, religiose, filosofiche, orientamento sessuale, razza);

- raccolta non mirata di immagini facciali da Internet o filmati di videosorveglianza per creare database di riconoscimento facciale;

- riconoscimento delle emozioni sul posto di lavoro e nelle istituzioni educative;

- punteggio sociale basato sul comportamento sociale o sulle caratteristiche personali;

- sistemi di intelligenza artificiale che manipolano il comportamento umano per aggirare il loro libero arbitrio;

- uso dell’IA per sfruttare le vulnerabilità delle persone (a causa della loro età, disabilità, situazione sociale o economica).

Esenzioni per le forze dell'ordine

Sono garantite eccezioni limitate per l’uso dei sistemi di identificazione biometrica in spazi accessibili al pubblico per scopi di contrasto della criminalità, previa autorizzazione giudiziaria, e per elenchi di reati rigorosamente definiti, da utilizzare rigorosamente nella ricerca mirata di una persona condannata o sospettata di aver commesso un reato grave.

L’utilizzo di questi sistemi in tempo reale deve rispettare condizioni rigorose e il suo utilizzo dev’essere limitato nel tempo e nel luogo, allo scopo di:

- ricerche mirate delle vittime (sequestro, tratta, sfruttamento sessuale),

- prevenzione di una minaccia terroristica specifica e attuale,

- la localizzazione o l'identificazione di una persona sospettata di aver commesso uno dei reati specifici menzionati nella norma (ad esempio terrorismo, tratta, sfruttamento sessuale, omicidio, rapimento, stupro, rapina a mano armata, partecipazione a un'organizzazione criminale, reati ambientali).

Obblighi per i sistemi ad alto rischio

Per i sistemi di IA classificati come ad alto rischio (a causa del loro significativo potenziale danno alla salute, alla sicurezza, ai diritti fondamentali, all’ambiente, alla democrazia e allo Stato di diritto), sono stati concordati obblighi chiari.

Gli eurodeputati sono riusciti con successo a includere, tra gli altri requisiti, una valutazione d'impatto obbligatoria sui diritti fondamentali, applicabile anche ai settori assicurativo e bancario. Anche i sistemi di intelligenza artificiale utilizzati per influenzare l’esito delle elezioni e il comportamento degli elettori sono classificati come ad alto rischio. I cittadini avranno il diritto di presentare reclami sui sistemi di intelligenza artificiale e ricevere spiegazioni sulle decisioni basate su sistemi di intelligenza artificiale ad alto rischio che incidono sui loro diritti.

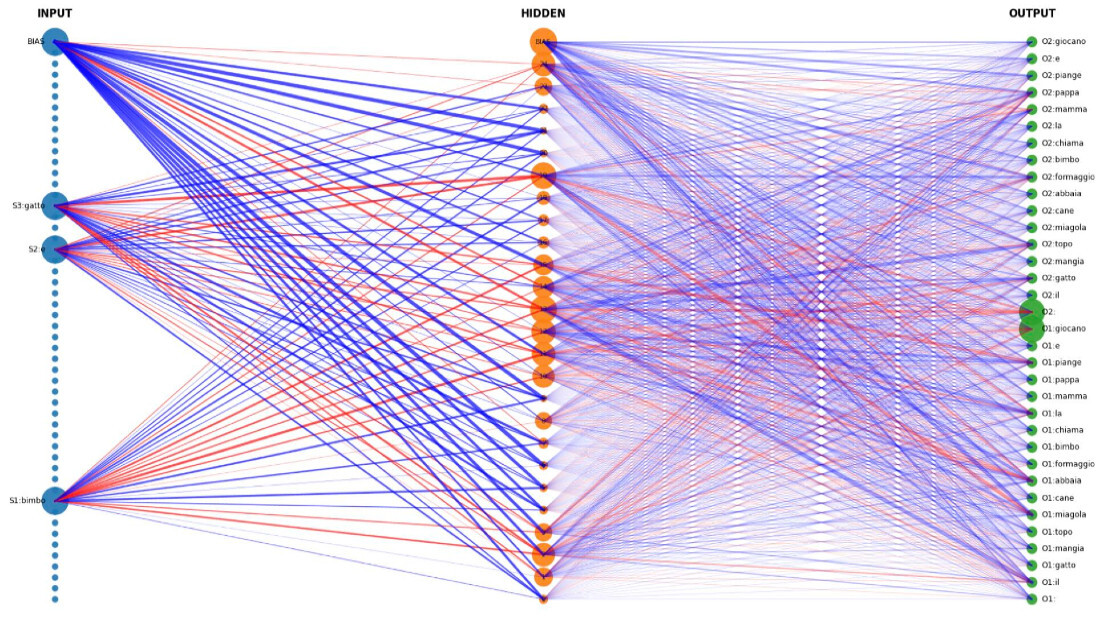

Barriere per i sistemi generali di intelligenza artificiale

Per tenere conto dell’ampia gamma di compiti che i sistemi di intelligenza artificiale possono svolgere e della rapida espansione delle loro capacità, è stato concordato che i sistemi di intelligenza artificiale per scopi generali (GPAI) e i modelli GPAI su cui si basano dovranno aderire ai requisiti di trasparenza come inizialmente proposto dal Parlamento. Questi includono la stesura di documentazione tecnica, il rispetto della normativa UE sul diritto d'autore e la diffusione di riepiloghi dettagliati sui contenuti utilizzati per la formazione. Per i modelli GPAI ad alto impatto con rischio sistemico gli obblighi sono più rigorosi e devono garantire la sicurezza informatica e l’efficienza energetica.

Misure a sostegno dell'innovazione e delle PMI

Si vuole garantire che le imprese, in particolare le PMI, possano sviluppare soluzioni di intelligenza artificiale senza indebite pressioni da parte dei giganti del settore. A tal fine, l’accordo promuove le cosiddette sandbox regolamentari (ambienti controllati dove operatori del settore possono testare, per un periodo di tempo limitato, prodotti e servizi tecnologicamente innovativi) e test nel mondo reale, istituiti dalle autorità nazionali per sviluppare e formare un’intelligenza artificiale innovativa prima del collocamento sul mercato.

Sanzioni ed entrata in vigore

Il mancato rispetto delle norme può portare a sanzioni che vanno da 35 milioni di euro o il 7% del fatturato globale a 7,5 milioni o l’1,5% del fatturato, a seconda della violazione e delle dimensioni dell’azienda.

Il testo concordato dovrà ora essere adottato formalmente sia dal Parlamento che dal Consiglio per diventare legge dell’UE.

© Riproduzione riservata