Un elemento cruciale, quando si ragiona di etica, è comprendere che essa non riguarda soltanto l’accordo su una serie di principi: l’etica riguarda il cambiamento dei nostri modi di agire. Non ha a che vedere con una lista fissa di cose da fare o da non fare: l’etica ha piuttosto a che fare con una discussione su come ciò che facciamo ricada sulle vite degli altri, e se tali effetti siano accettabili o inaccettabili.

Questo ragionamento e queste argomentazioni valgono, in un senso ancora più marcato e cruciale, per l’etica dell’AI. Esaminare seriamente le posizioni in campo conduce ad affrontare la questione della realizzabilità degli obiettivi che gli esseri umani attribuiscono all’intelligenza artificiale (la sua fattibilità), ma soprattutto – dal punto di vista etico – porta a affrontare la questione della sua desiderabilità, in termini morali, ma anche in termini di felicità e di equità.

Etica e Al, etica dell'Al

Se accettiamo il fatto che lo studio de1l’etica e dei principi etici sia costantemente in evoluzione, e si sviluppi in un certo senso minuto dopo minuto, l’elemento di maggior difficoltà, nel passaggio dalle teorie alle applicazioni in contesti che ‘chiedono’ etica, non sarà tanto comprendere che cosa sia l’etica, ma lavorare sul legame che intercorre tra principi etici e pratiche (che spesso si identificano con pratiche politiche).

Consideriamo un esempio, relativo alla cosiddetta ethical data science: la ‘scienza etica dei dati’ si basa su un insieme di principi e valori che enfatizzano l’equità, la trasparenza, la responsabilità e il rispetto dei diritti individuali. Questi principi fondamentali forniscono le basi per prendere decisioni etiche durante l’intero ciclo di vita della scienza dei dati, secondo la regola del treat others’ data as you would have others treat your own data. Noi disponiamo, peraltro, già di ottimi standard etici per la gestione di dati: la protezione dei dati, la gestione della privacy e l’offerta di servizi online trasparenti sono considerati i tre pilastri fondamentali della data ethics, e io sono profondamente convinta che la maggioranza dei data analysts e data scientists ambiscano ad essere professionalmente oggettivi, equi, rispettosi, in una parola fair: gli sviluppatori di software non vogliono recare danno alle persone che usano i loro prodotti (ci sono, certo, eccezioni, ma non rappresentano un campione statisticamente significativo).

In altre parole, il punto davvero rilevante quando si affronta l’etica dei dati e dell’AI è che discutere o ragionare, in prima battuta, in termini di impegni astratti alla fairness non si rivelerà ne utile né opportuno: i principi utili sono i principi in grado di cambiare le pratiche, e ciò che dobbiamo capire è come costruire sistemi di software che implementino, modificandole in caso di necessità, misure di equità. Ogni codice deontologico legato all’uso di dati sarà in grado di dirvi che non dovete raccogliere dati su soggetti sperimentali senza un consenso informato. Ma lo stesso codice non sarà in grado di dire come implementare il consenso informato dei soggetti sperimentali: il principio del consenso informato è, cioè, molto semplice, quando si devono intervistare una dozzina di persone per un esperimento, ma diventerà qualcosa di molto diverso e decisamente più problematico e meno controllabile quando si cliccherà su un catalogo commerciale online.

La comprensione dei principi etici si rivela così essere, nella sostanza, molto diversa dal1’imp1ementazione degli stessi principi, e ragionare sul tema del1’Al, sul suo rapporto con l’etica, e sulla possibilità di sviluppare un’AI etica potrà, forse, servire per comprendere meglio questa fondamentale distinzione: in un contesto di AI, un’etica deii’AI dovrà essere in grado di specificare per un verso gli obblighi morali e i doveri di una Al, e per un altro verso anche, forse soprattutto, gli obblighi morali e i vincoli dei suoi creatori.

Il caso Hanooman

È quindi opportuno, a questo punto, sottolineare che ogni pretesa di compilare un catalogo completo di concetti o principi normativi per l’etica applicata a1l’AI deve inesorabilmente fare i conti con la pluralità di punti di vista su ciò che è bene o giusto fare, con le interpretazioni dei principi morali che possono variare in funzione dei contesti applicativi, e con la singolare evoluzione culturale delle sensibilità morali.

Mentre scrivo queste righe il ruolo, finora modesto, giocato per esempio dall’India nel mondo dell’AI sembra destinato a crescere esponenzialmente con il lancio di Hanooman, un Large Language Model (LLM) sul modello di ChatGPT, in grado di interagire in undici delle ventidue lingue ufficiali del Paese. Il modello, promosso da Bhashini, un’agenzia governativa, e dall’1ndian Institute of Technology (IIT) di Bombay, capofila di un gruppo di atenei collocati in diversi stati indiani, avrà applicazioni in quattro grandi aree: salute, istruzione, servizi finanziari e goverrtnnce. Una scelta non casuale, quella di diversificare geograficamente la composizione del consorzio, visto che lo scopo dichiarato dell’iniziativa è quello di rendere l’AI alla portata anche di quei vasti strati della popolazione indiana che non sanno esprimersi in inglese. Tra le undici lingue in cui sarà disponibile il modello ci sono alcune di quelle di ceppo indo-ariano, come l’Hindi, popolare a Delhi e in alcuni stati del Nord del1’lndia, il Bengali, parlato a Kolkata e il Marathi, la lingua più diffusa a Mumbai, nonché una serie di lingue dravidiane parlate nel Sud, come il Tamil, il Telugu e il Malayalam. In un video di presentazione di Hanooman proiettato durante una conferenza a Mumbai si sono visti un meccanico fare una domanda a un Bot in Tamil, un banchiere chiedere delucidazioni in Hindi, e uno sviluppatore di Hyderabad, dove si parla Telegu, ricorrere all’aiuto del1’AI per fare del coding.

I promotori del progetto, responsabili del dipartimento di Ingegneria e Scienze informatiche dell’IIT di Bombay, hanno spiegato che Hanooman offrirà la possibilità di convertire la voce in testo, per andare incontro ai milioni di indiani che non sanno né leggere né scrivere. A tal proposito, tuttavia, colpisce, tra le prime undici lingue, l’assenza dell’Urdu, la settima lingua più parlata del Paese e la più diffusa tra la popolazione musulmana. Un dato che, unito alla scelta del nome del modello di AI (Hanooman evoca il nome di una popolare divinità induista, Hanuman) si pone come un indice evidente delle finalità eticamente controverse — perlomeno in termini di inclusione — del progetto: la comunità musulmana ha alcuni degli indicatori sociali e di reddito peggiori del Paese, e potrebbe beneficiare più di altre dell’accesso non mediato a informazioni di tipo, per esempio, educativo e sanitario, specialmente nel caso delle donne e dei giovani. Questo è solo un esempio, tra tanti e tra i più recenti, dei possibili futuri utilizzi dell’Al per, in questo caso, colmare le distanze linguistiche e culturali che frammentano un Paese che conta 1,5 miliardi di abitanti. Futuri utilizzi promettenti dal punto di vista della feasibility, ma anche futuri possibili abusi dal punto di vista di un’etica dell’IA, o della sua desirability. L’etica dell’AI, in altri termini, è ancora — temo — nella sua fase iniziale di sviluppo, nel suo infancy stage. Ma potrebbe non essere questo l’elemento più controverso — e filosoficamente più interessante — della questione.

L’altra faccia della medaglia

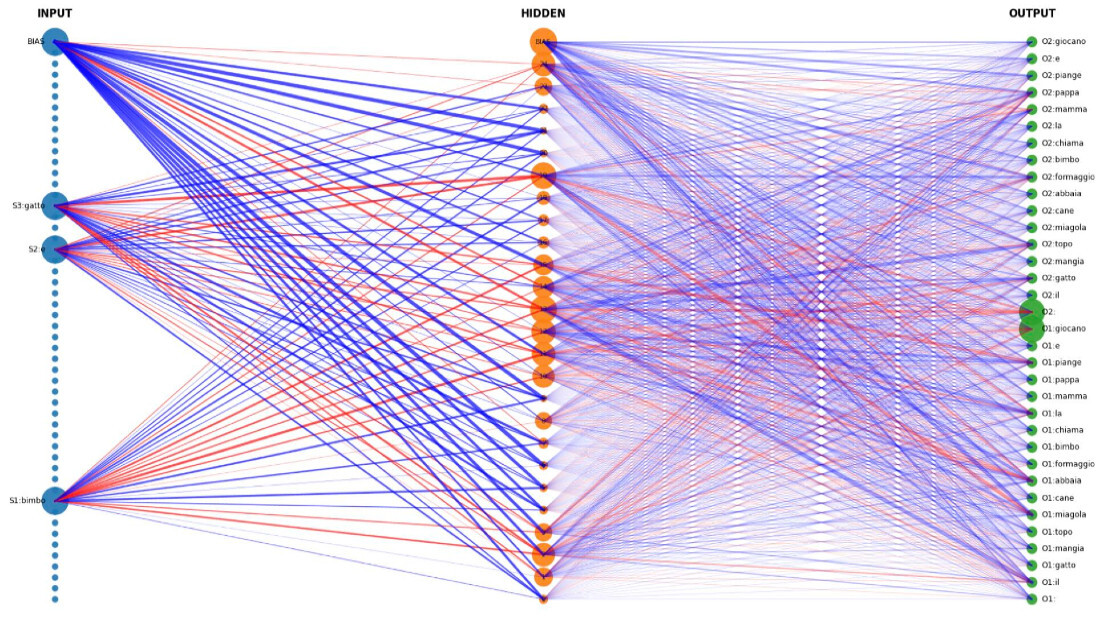

I sistemi di intelligenza artificiale rappresentano una tecnologia radicalmente nuova rispetto ai precedenti sistemi esperti ’basati su regole’, specialmente per le loro capacità di autoapprendimento. La loro diffusione rapida nel mondo del lavoro ha suscitato un vivace dibattito pubblico incentrato sui loro effetti non intenzionali, poiché vengono chiamati a prendere decisioni (sempre più numerose e rilevanti) basate sulla conoscenza sviluppata autonomamente — e quindi spesso opaca — a livello di fini ultimi. Gli sviluppatori di intelligenza artificiale tendono tipicamente a sottolineare la superiorità dei loro strumenti contrastando l’oggettività e la superiorità delle intuizioni fornite dall’AI con la “soggettività” utilizzata dagli esperti del settore o con le limitazioni delle loro capacità cognitive, anche se si tratta di un problema ampiamente dibattuto e oggetto di disaccordi genuini e radicali. ln merito a questa discussione, la visione dominante nella ricerca gestionale è che il rischio di conseguenze indesiderate delle scelte basate sull’AI sia il risultato dei loro (ancora) scadenti “modelli del mondo”. Ad esempio, le auto a guida autonoma sono tuttora insicure poiché i loro modelli algoritmici non riescono ancora a gestire la complessità della guida nel mondo reale. Pertanto rimane aperta la domanda sul tempismo: quando i modelli algoritmici su cui tali auto basano le loro scelte saranno considerati “abbastanza sicuri”?

Questa formulazione del problema potrebbe, da un lato, sottovalutare i rischi associati alle conseguenze non intenzionali dell’AI, una visione che si basa, infatti, su una dualità tra mezzi e fini, in cui i fini — guidare in modo sicuro ed efficiente da un luogo A ad un luogo B — sono definiti dagli esseri umani, e i mezzi — il modo di procedere e le “micro” scelte lungo il percorso, come accelerare o frenare — sono definiti dall’Al. In altre parole, questa formulazione presume che l’AI non possa modificare i suoi obiettivi finali. Attingendo all’idea filosofica di piena autonomia (il precetto kantiano di darsi le proprie regole), e osservando gli sviluppi recenti nei dibattiti di filosofia politica e di etica dell’AI, si potrebbe suggerire l’ipotesi che i sistemi di intelligenza artificiale potranno — in un futuro non così remoto — non solo essere caratterizzati da autonomia parziale (definire il modo di procedere), ma potranno potenzialmente essere caratterizzati da un livello di autonomia completa (decidere dove andare). In effetti, una visione filosoficamente informata della relazione tra mezzi e fini potrebbe aiutare a superare l’idea della loro dualità che ancora domina la ricerca gestionale, presagendo che sistemi artificiali (veramente) intelligenti saranno in misura, prima o poi, di sviluppare una comprensione del mondo che li porterà a ottimizzare non solo i mezzi, ma anche i fini.

Tali fini, infatti, sono interpretati dal sistema di intelligenza artificiale in relazione alla sua “visione del mondo”, che, date le sue capacità di autoapprendimento, cambia costantemente. Pertanto, dal momento che persino l’obiettivo pin tecnicamente specificato assegnato a un sistema di intelligenza artificiale non può essere completamente e eternamente inequivocabile, il sistema di intelligenza artificiale reinterpreterà — presto o tardi — (cioè, potenzialmente, cambierà) l’obiettivo.

Questa idea di un sistema di AI completamente autonomo potrebbe costituire una nuova immagine del pensiero per la ricerca gestionale, poiché apre a interrogativi e preoccupazioni etiche di cui le visioni dominanti sembrano non essere pienamente consapevoli. Intelligenza artificiale, machine-learning, robotica, reti neurali: sono solo alcune delle espressioni che ci fanno pensare a trasformazioni rapidissime che pochissimi comprendono e forse nessuno potrà controllare. Non sono in grado di dire se sia davvero così, ma vorrei infine suggerire l’idea che possa anche esiste un’altra, inaspettata, faccia della medaglia.

Conclusioni: Macchine come me, persone come voi

“Questi venticinque uomini e donne artificiali immessi nel mondo non stanno affatto bene. Potremmo trovarci di fronte a una condizione limite, a un confine che ci siamo imposti da soli. Abbiamo creato una macchina intelligente e consapevole e l’abbiamo gettata nel nostro mondo imperfetto. Ideata in base ai principi generali della ragione, ben disposta nei confronti dell’altro, una mente di questo tipo precipita ben presto dentro una bufera di contraddizioni. Noi ci siamo abituati, e il solo elenco ci sfinisce. Milioni di individui che muoiono di malattie di cui abbiamo la cura. Milioni che vivono nella povertà quando ci sarebbe il necessario per tutti. Danneggiamo la biosfera quando sappiamo che è l’unica nostra casa. Ci minacciamo reciprocamente con le armi nucleari pur sapendo a cosa potrebbero portarci. Amiamo gli esseri viventi ma permettiamo l’estinzione in massa di intere specie. E poi tutto il resto: genocidi, torture, schiavitù, violenze domestiche, abusi sui minori, sparatorie nelle scuole, stupri e altre decine di orrori quotidiani. Viviamo circondati da questi tormenti e non siamo neppure stupiti di riuscire comunque a rimediare un po’ di felicità, e addirittura amore. La mente artificiale non ha le stesse difese. Secondo me gli Adam & Eve non erano attrezzati per capire i processi decisionali umani, il modo in cui i nostri principi vengono distorti dal campo di forze di emozioni, pregiudizi, autoinganni e di tutti i sistematici errori delle nostre funzioni cognitive. In poco tempo, questi Adam e queste Eve si ritrovavano senza speranza. Non riuscivano a capirci, perché noi stessi non ci capiamo. I loro programmi di apprendimento non erano in grado di contemplarci. Non conoscendo la nostra mente, come avremmo potuto progettare la loro e aspettare di vederli felici al nostro fianco? Vorrei poterle dimostrare l’autentica meraviglia filosofica, la logica squisita, la bellezza e l’eleganza della soluzione del problema P e NP, e il lavoro illuminante che migliaia di uomini e donne onesti, geniali e instancabili hanno dedicato alla costruzione di queste nuove forme di intelligenza. Le restituirebbe ottimismo nei riguardi dell’umanità. Ma niente nello splendore di tutti i loro codici potrebbe mai preparare Adam e Eve per Auschwitz”.

Londra, un altro 1982. La guerra delle Falkland si é conclusa con la sconfitta dell’Inghilterra, i quattro Beatles hanno ripreso a calcare le scene, Alan Turing è vivo (ed e lui a parlare nel testo più sopra citato). In Macchine come me, titolo ispirato da un libro di lsaac Asimov, Ian McEwan presenta un passato alternativo, un’ucronia in cui il trentaduenne protagonista, Charlie Friend, può usare l’eredità che gli ha lasciato la madre per comprarsi un robot: Adam. Bellissima e potente, dotata di un nome e di un corpo, la macchina ha intelligenza, sentimenti e una coscienza propria. Ma mente e cervello, il buon vecchio problema senza soluzione, è difficile per 1e macchine non meno che per g1i umani, e si ripropongono anche qui1e tensioni costanti tra libertà e controllo, disciplina e sorveglianza, opportunità e rischi, benefici e costi. L’AI è paradigmatica di queste tensioni talvolta paradossali.

La scienza e la tecnologia sono in grado di condurre i soggetti umani a un nuovo stadio evolutivo che consenta loro di espandere indefinitamente le proprie capacità e superare i limiti (invecchiamento, malattia, sofferenza, morte) che da sempre sebmano l esperienza umana? Le macchine ereditano i pregiudizi di coloro che le programmano (machine learning dilemma)? Quali sono le percepite questioni etiche e morali legate all’AI? Quali sono i principi etici, le regole, le linee guida, le politiche e le normative generali e comuni che possono risolvere o almeno attenuare queste questioni etiche e morali legate all’AI? Quali sono alcune delle caratteristiche e degli attributi necessari di un’AI etica? Come aderire a1l’etica de1l’AI per costruire un’AI etica?

Queste sono solo alcune delle nuove domande, che si aggiungono alle domande classiche della filosofia, dell’etica, e anche della teoria politica. A nuove domande corrisponderanno allora nuovi scopi, ed obiettivi: se la definizione del limite che stabilisce quanto le macchine intelligenti possano invadere le nostre vite è un tema che riguarda l’etica e i diritti, prima ancora che la tecnologia, allora la misura del potere e della diffusione delle Al deve andare di pari passo con la definizione di questo limite. Il tema dell’AI — nelle sue declinazioni plurali (transhumanism, roboethics, artfJicial intelligence) — invita a comprendere un cambiamento che è già in atto: il diritto dovrà comprendere per regolamentare, la filosofia e l’etica vorranno e dovranno invece comprendere per giustificare e/o delegittimare. Una riflessione etico-filosofica consapevole e responsabile dovrà quindi confrontarsi con ognuno di questi tentativi, per valutare se e quanto le scienze della mente contemporanee costituiscano un contributo alla soluzione delle questioni filosofiche tradizionali, ovvero consentano di modificarle, aggiornarle e, perché no, anche rimuoverle.

Filosofia dell’Intelligenza Artificiale. Sfide etiche e teoriche

Bibliografia

G. TAMBURRINI, Etica delle machine. Dilemmi morali per robotica e intelligenza artificiale, Roma, 2020.

R. CAPURRO, M. NAGENBORG, Ethics and Robotics, IOS Press, Amsterdam, 2018

W. F. LAWLESS, R. MITTU, D. SOFGE, S. RUSSELL (eds), Autonomy and Artificial Intelligence: a Threat or Savior, Springer, New York, 2017.

V. C. MULLER, Philosophy and Theory of Artificial Intelligence, Springer, New York, 2014; T. METZINGER, The Ego Tunnel. The Science of the Mind and the Myth of the Self, Basic Books, New York, 2009; tr. it. di M. BACCARINI, Il tunnel dell’io. Scienza della mente e mito del soggetto, Raffaello Cortina, 2010

I. MCEWAN, Macchine come me, Einaudi, 2020, 198.

N. BOSTROM N., A History of Transhumanist Thought, in Journal of Evolution and Technology, vol.14, 1-25, 2005; In difesa della dignità postumana, in Bioetica, 4, 33-46, 2005.

S. I. EDGAR, Morality and Machines, Sudbury, MA, Jones and Bartlett Publishers, 1997.

P. BARCELLONA, L’epoca del postumano, Città Aperta, 2007

© Riproduzione riservata