L’AI Revolution

La recente nascita e lo sviluppo amplificato di ChatGPT pone interrogativi molteplici: uno di questi è l’ LLM (Large Language Model) di OpenAI messo a disposizione del pubblico sotto forma di chatbot nell’autunno del 2022. A nemmeno due anni dal suo lancio, ChatGPT ha già fortemente impattato il modo di lavorare di giornalisti, analisti e accademici, che per professione devono relazionarsi quotidianamente con il linguaggio scritto. E se la contrapposizione tra consumatori entusiasti e tenaci detrattori non può dirsi del tutto superata, possiamo affermare con ragionevole certezza che la maggior parte dei professionisti ha ormai accettato come inevitabile l’ingresso dell’Intelligenza Artificiale nel mondo del lavoro. Lo dimostra il fiorire di blog post, report, e articoli scientifici dedicati all’utilizzo efficacie e intellettualmente onesto degli AI-powered language models per la scrittura. Ma da dove arrivano gli LLMs? Per scoprirlo, in questo articolo facciamo qualche passo indietro – nel tempo e nel progresso tecnologico – per arrivare al primo chatbot della storia: ELIZA.

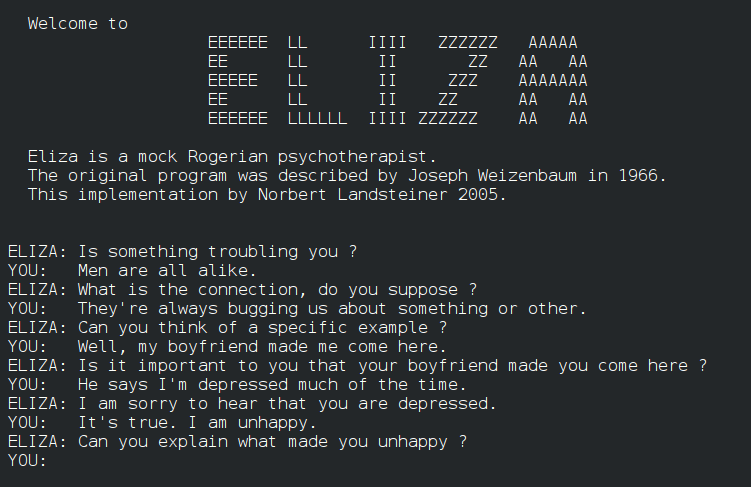

Gli inizi: ELIZA e gli albori dell'interazione uomo-macchina

Nel 1966, un software chiamato ELIZA fece il suo debutto come uno dei primi tentativi di creare un'interfaccia per la conversazione uomo-macchina. Sviluppato da Joseph Weizenbaum al MIT, ELIZA utilizzava semplici tecniche di pattern matching per simulare una conversazione. In sostanza, questo chatbot di primissima generazione si limitava a riformulare il testo, che gli veniva fornito dall’utente, in forma di domanda rivolta all’utente stesso. In questo modo ELIZA creava l’illusione di una conversazione uomo-macchina. ELIZA operava attraverso una serie di script, il più famoso dei quali era DOCTOR, che tentava di emulare le risposte di uno psico-terapeuta (cliccate qui per parlare con ELIZA e vedere l’effetto che fa). La capacità di ELIZA di restituire frasi che apparivano sensate, affascinò e al contempo preoccupò i suoi utenti, non molto diversamente da come succede oggi con ChatGPT. L'intuizione di Weizenbaum era che anche semplici trasformazioni linguistiche potevano dare un’illusione d’intelligenza, una scoperta che avrebbe influenzato profondamente lo sviluppo della programmazione linguistica (in inglese, Natural Language Processing o NLP).

Gli anni ‘80: l’avvento dei Neural Networks

Software come ELIZA appartengono alla categoria dei cosiddetti rule-based systems. Questi sistemi erano progettati per risolvere problemi specifici utilizzando vasti database di conoscenze e regole predefinite. Tuttavia, la mancanza di flessibilità e l'incapacità di gestire l'ambiguità linguistica limitarono le loro applicazioni. Alla fine degli anni Ottanta, però, i modelli di linguaggio iniziarono a evolversi rapidamente grazie alla statistica e al machine learning. Il lavoro pionieristico di ricercatori come Geoffrey Hinton portò allo sviluppo dei cosiddetti neural networks (reti neurali artificiali), aprendo la strada a tecniche più avanzate per l'elaborazione del linguaggio naturale. Questi modelli di elaborazione delle informazioni si ispiravano proprio alla struttura e al funzionamento del cervello umano. Nei neural networks, infatti, le informazioni vengono elaborate e redistribuite tra i vari “neuroni artificiali” attraverso connessioni che simulano le sinapsi biologiche: una delle fondamentali rivoluzioni nel campo dell’Intelligenza Artificiale che introduce una competenza quasi poetica.

Intelligenti ma ancora un po’ ‘smemorati’: i Recurrent Neural Networks

Nel 1986, una nuova generazione di neural networks, gli RNN (Recurrent Neural Networks), aprì la strada all’utilizzo delle reti neurali nella programmazione linguistica. Ma come, viene da chiedersi? È tutta questione di memoria. A differenza dei loro predecessori, infatti, questi modelli erano in grado di immagazzinare gli input ricevuti nella propria memoria interna (almeno per un po’). Questo permetteva loro non solo di elaborare le informazioni presenti in un testo, ma anche di “tenerle a mente” abbastanza a lungo da poter, ad esempio, rispondere a domande inerenti al testo stesso. Un RNN che si trovasse a “leggere” una frase come questa: “Mario sta giocando a calcio al parco”, sarebbe in grado di rispondere a domande come: “Chi sta giocando?” “A cosa sta giocando?” “Dove”? Un epocale passo avanti rispetto a sistemi come ELIZA: dall’illusione dell’intelligenza all’Intelligenza Artificiale. Il problema degli RNN stava, però, nella loro limitata capacità di memoria. Un RNN a cui venisse fornita questa frase più lunga: “Mario sta giocando a calcio al parco, con due dei suoi compagni di scuola”, non riuscirebbe a rispondere correttamente alla domanda: “Chi sta giocando?” In questo caso, infatti, l’RNN non riuscirebbe a “ricordare” chi sia il soggetto della frase – “Mario” – perché seguito da una sequenza troppo lunga di parole. Per fare un parallelo col caso umano, gli RNN erano un po’ come una persona che soffre di deficit della memoria a breve termine. Assomigliavano a Dory, per intendersi (il pesce chirurgo blu della Disney).

Gli anni ‘90: i Recurrent Neural Networks rivedono le loro priorità

Nel 1997 finalmente arrivò una nuova generazione di RNN, chiamati LSTM (Long Short-Term Memory). Questi modelli erano in grado di mantenere informazioni nella propria memoria interna più a lungo rispetto ai primi RNN. Ma qual era il segreto degli LSTM? Questa volta, è tutta questione di priorità. Gli LSTM si distinguevano, infatti, per la loro capacità selettiva di memorizzare e dimenticare. Invece di tentare, fallendo, di mantenere in memoria tutti gli input ricevuti, gli LSTM erano in grado di selezionare le informazioni rilevanti e di scartare quelle non necessarie. Un po’ come quando alle elementari ci insegnavano a evidenziare le nozioni più importanti tra le pagine del sussidiario. Grazie alla loro memoria selettiva, gli LSTM costituivano quindi uno strumento molto più efficace per la programmazione linguistica. Ma il bello doveva ancora venire…

Gli anni 2000: All you need is … Attention!

La seconda svolta epocale nel mondo della programmazione linguistica avvenne nel 2014, con l’introduzione del concetto di “attenzione” pubblicato per la prima volta in un paper scientifico. L’introduzione del cosiddetto attention mechanism segnò un significativo cambio di paradigma, offrendo una prospettiva nuova rispetto alle architetture precedenti. In quale senso e direzione? Questa volta, è tutta questione di dinamicità. Tutti gli RNN infatti, anche gli LSTM, racchiudono tutte le informazioni di una frase di partenza in un unico vettore di contesto di lunghezza fissa. Per questo motivo, le loro prestazioni peggiorano con l'aumentare della lunghezza della frase. I modelli basati sull’attention mechanism, invece, riescono a guardare all'intera frase di origine in modo dinamico, “saltando” da una parte all’altra della sequenza per selezionare le parole chiave. Questo garantisce che nessuna informazione cruciale venga persa o diluita, soprattutto nelle sequenze più lunghe. Supponiamo, ad esempio, di voler tradurre una frase come questa: “I fed my cat because it was hungry”, dall’inglese all’italiano, o al francese. Un modello LSTM leggerebbe ed elaborerebbe prima l'intera frase, immagazzinando le parole chiave “I”, “fed”, “cat” e “hungry” nella sua memoria interna. Dopodiché, inizierebbe a tradurre. A questo punto, però, avrebbe problemi a tradurre la parola “it”, che aveva scartato perché non rilevante, e che quindi non saprebbe più correttamente ricondurre alla parola “cat”. Un modello basato sull’attention mechanism, invece, avrebbe la capacità di riguardare l'intera frase in inglese quando traduce la parola “it”, evidenziando la parola “cat” come rilevante, e quindi riuscendo a tradurre accuratamente “it”.

Fu proprio l’attention mechanism a ispirare l’architettura dei Transformer, introdotti da Google nel 2017 con la pubblicazione dell’ormai celebre paper intitolato “Attention is all you need”.

La caratteristica fondante dei modelli Transformer è la multi-head attention, che permette di concentrarsi contemporaneamente su diverse parti della frase in ingresso, cogliendo varie sfumature contestuali simultaneamente. Un altro punto di forza molto rilevante è la loro capacità di elaborare sequenze in parallelo, anziché in sequenza, rendendo l’elaborazione del linguaggio più efficace ed efficiente. È stata proprio questa architettura a gettare le basi per modelli successivi come BERT, GPT e altri ancora, che ci hanno portato in una nuova era del NLP.

2018-2019: L’Ascesa degli LLMs con BERT e ChatGPT

Nel 2018 Google presentò il suo primo LLM: BERT. A differenza dei modelli precedenti, che elaboravano il testo da sinistra a destra o da destra a sinistra, BERT era progettato per considerare entrambe le direzioni contemporaneamente grazie, appunto, alla multi-head attention. Il suo nome, Bidirectional Encoder Representations from Transformers (BERT), deriva proprio da questa sua caratteristica così innovativa da avere aperto la strada a una nuova generazione di modelli per la programmazione linguistica – gli LLMs appunto – che hanno permesso una comprensione e generazione computerizzata del linguaggio senza precedenti. Dopo BERT, abbiamo visto comparire una molteplicità di LLMs, da quelli free-source come Llama, a quelli a pagamento (e probabilmente molto più famosi) come GPT, presentato per la prima volta da OpenAI nel 2018.

Il 2020: L’ultima svolta con GPT-3 e il boost di GPT-4

Dalla sua introduzione nel 2018, il modello basato sul Generative Pre-Training (GPT) di OpenAI si è già notevolmente evoluto. La vera svolta c’è stata con l'introduzione di GPT-3 nel 2020.

Grazie ai suoi 175 miliardi di parametri, GPT-3 ha dimostrato capacità straordinarie nella generazione di testo, traducendo lingue, rispondendo a domande, e persino scrivendo codice. Dal 2022 poi, GPT è stato reso disponibile al pubblico sotto forma di chatbot, apparentemente rendendo alla portata di tutti l’NLP. Tuttavia, nonostante le sue impressionanti capacità, ChatGPT ha già sollevato preoccupazioni etiche e pratiche per la sua tendenza a riprodurre gli stessi bias e stereotipi contenuti nei dati con cui veniva “allenato”. L’ultima versione di GPT al momento disponibile è ChatGPT-4, lanciata da OpenAI nel 2023, che vanta miglioramenti significativi in termini di comprensione contestuale, creatività e capacità di apprendimento grazie, tra le altre cose, all'integrazione di tecniche avanzate di fine-tuning.

Un viaggio in continua evoluzione

Siamo dunque arrivati alla fine del nostro viaggio nella storia degli LLMs, e all’apice dell’evoluzione della programmazione linguistica. Un lettore attento avrà, tuttavia, già intuito che questo punto di arrivo è, in effetti, soltanto una sosta temporanea.

Gli LLMs, come molte delle tecnologie odierne, sono in continua evoluzione. Se volgiamo lo sguardo al futuro dei Large Language Models, è chiaro che queste tecnologie continueranno a trasformare il modo in cui interagiamo con le macchine. Tuttavia, questa loro continua evoluzione pone anche sfide significative. La questione dei bias e degli stereotipi riprodotti da alcuni di questi modelli, la possibilità di disinformazione e l'uso etico dell'AI sono temi cruciali che richiedono una riflessione approfondita e una regolamentazione adeguata. Dal rudimentale ma pionieristico script di ELIZA alle più sofisticate reti neurali di GPT-4, il viaggio dei Large Language Models si è caratterizzato per continui avanzamenti tecnologici e innovazioni. Questi modelli non hanno soltanto rivoluzionato il campo del Natural Language Processing, hanno anche aperto nuove possibilità per l'interazione uomo-macchina. In questo contesto di continua evoluzione, abbiamo voluto offrire una (non-troppo-tecnica) panoramica dell’evoluzione degli LLMs, così da dare a chi legge le nozioni fondamentali per capire il potenziale, i limiti, e le sfide che questi modelli offrono.

In conclusione e in estrema sintesi, dunque, i language models basati sull’IA non sono dannosi o benefici di per sé. Come tutte le tecnologie, gli LLMs possono essere utilizzati in maniera più o meno efficacie ed etica: conoscerne la storia e l’evoluzione è sicuramente un ottimo punto di partenza per maneggiarli come si deve.

© Riproduzione riservata