Uno spoiler: questo articolo non è stato scritto da ChatGPT.

Ho scelto di scriverlo di persona, impiegandoci qualche ora, mentre avrei potuto ottenere un risultato di qualità simile facendo opportune domande al chatbot di OpenAI, con un modesto lavoro di editing sulle risposte. Non fa nessuna differenza il fatto che ChatGPT sia attualmente disabilitato in Italia dopo l’intervento del Garante della Privacy: con pochi Euro si possono scaricare semplici applicazioni che consentono di simulare la connessione da altri paesi tramite il protocollo VPN, in modo completamente legale.

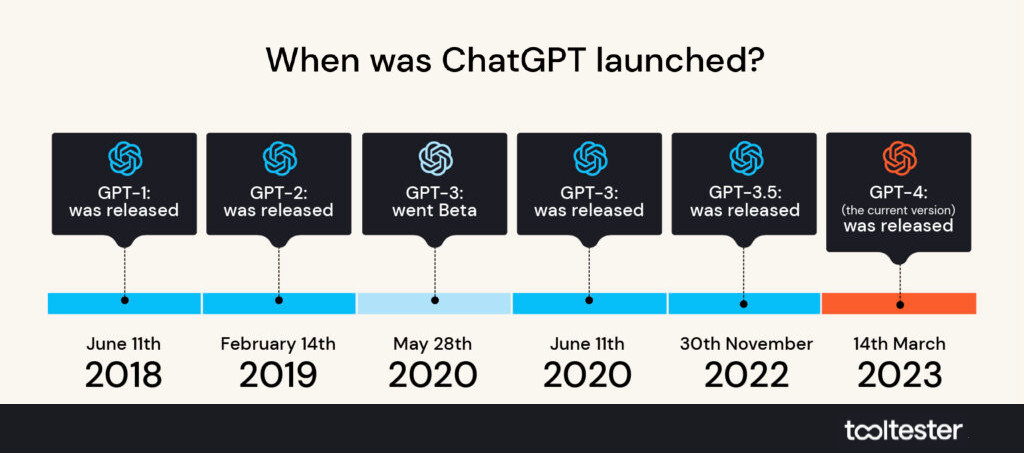

ChatGPT è la più recente innovazione nel capo dell’intelligenza artificiale (AI): un bot interattivo in grado di rispondere in un linguaggio umano e naturale alle più svariate domande dell’utente. A richiesta, scrive sonetti nello stile di Shakespeare, pontifica sui buchi neri, genera software funzionante in diversi linguaggi di programmazione, supera esami di livello universitario, sintetizza documenti, produce bibliografie, traduce in modo fluente in un gran numero di lingue, e molto altro. Il tutto (per il momento) al modico prezzo di venti dollari al mese.

Non sorprendentemente, la disponibilità di questo nuovo pirotecnico attrezzo di intelligenza artificiale ha generato (almeno nei media dei paesi democratici, dove i commenti sono liberi) una vasta gamma di reazioni, tendenzialmente molto polarizzate, e spesso non di poco fuori misura. Da un lato leggiamo di utopie secondo cui l’intelligenza artificiale "risolverà i problemi dell’umanità", "migliorerà gli standard di vita" e "scoprirà usi nuovi e migliori per la creatività umana". All’altro estremo le cupe profezie della lettera aperta firmata da Elon Musk e altri guru del mondo scientifico e tecnologico, che chiede una pausa nello sviluppo di questi sistemi, evocando la creazione di «menti non umane, che ci supereranno, ci renderanno obsoleti e ci rimpiazzeranno».

Manteniamo i piedi per terra

Credo che convenga invece mantenere i piedi saldamente piantati per terra. ChatGPT è certamente una innovazione radicale, e rappresenta un salto di qualità significativo nello sviluppo degli assistenti digitali. Ci vorrà parecchio tempo per capire le implicazioni scientifiche, economiche, sociali e psicologiche dell’avvento di questo nuovo tipo di macchina. Tuttavia, qualche piccola cosa si può dire subito, se non altro come base per future riflessioni.

Innanzi tutto, non ci sono dubbi sul fatto che ChatGPT sia una macchina. In particolare, è un Large Language Model (LLM): una gigantesca rete neurale (nel senso informatico del termine!) con 175 miliardi di parametri, che sono stati tarati con un immenso lavoro di addestramento, facendo "leggere" alla macchina praticamente l’intero contenuto di internet, e per un gran numero di volte, sotto la supervisione di uno squadrone di ingegneri informatici. Il funzionamento della macchina è statistico: le frasi vengono costruite con metodi probabilistici basandosi sul contesto fornito dalle parole adiacenti. Quello che rende la macchina così potente sono i due elementi cardine di tutti gli sviluppi dell’AI nell’ultimo decennio: la disponibilità di un immenso potere computazionale, e l’accessibilità di una straordinaria quantità di dati, che consentono ai metodi statistici un sorprendente livello di successo.

Questo ci conduce a una prima riflessione sui chatbot "intelligenti". Data la qualità linguistica dell’output, è difficile sfuggire all’impressione di avere a che fare con un interlocutore umano. Cruciale quindi ricordarsi: dall’altra parte, non c’è nessuno. Può sembrare una considerazione banale, ma non è difficile immaginare l’effetto psicologico di una nostra continua interazione con una macchina che produce grandi quantità di informazione in un linguaggio impeccabile e autorevole. Sarà necessario rimettere spesso a fuoco il fatto che non stiamo parlando con un esperto infallibile, con un guru sapiente, con un leader di opinione, e nemmeno semplicemente con un’altra persona, ma solo con una macchina addestrata con la statistica a nuotare nella grande vasca delle conversazioni umane.

Potenziali fabbriche di fake news

In particolare, un fatto. I chatbot non dispongono di criteri di verità, né, tantomeno, di regole morali. Rispondono in modo probabilistico sulla base dei testi sui quali sono stati addestrati. Non c’è quindi nessuna garanzia che le risposte siano corrette (anche se nella grande maggioranza dei casi per ora lo sono), né tantomeno che rispondano a qualche nozione di giustizia. Non è difficile trarre in inganno ChatGPT con giochetti di logica, o ricevere risposte prive di senso quando le domande si fanno troppo tecniche o intricate. Più seriamente, possiamo facilmente immaginare (e potremmo presto vedere in azione) chatbot addestrati su testi selezionati in modo tendenzioso per sostenere agende politiche o economiche. Che tipo di autorevoli risposte darebbe un chatbot addestrato in modo preferenziale sui volantini delle Brigate Rosse, o sull’intero scibile della pubblicistica nazi-fascista, da Mein Kampf ai quotidiani deliri del Völkischer Beobachter? E noi, sapremmo distinguere, se l’addestramento fosse fatto con cura statistica e un attento gioco di equilibri? In quale misura i chatbot possono ulteriormente contribuire alla produzione di fake news su scala industriale?

Le tre regole immaginate da Asimov

Isaac Asimov, preconizzando ottant’anni fa la creazione di robot in grado di interloquire con gli esseri umani in modo linguisticamente paritetico, ebbe la brillante idea di immaginare che le "menti" robotiche sarebbero state programmate, in modo indelebile e basilare, con tre leggi che ne avrebbero governato il comportamento in termini assoluti. «I robot non possono far del male agli esseri umani, né permettere che essi subiscano danno. I robot devono obbedire agli esseri umani, tranne se questo entra in conflitto con la prima legge. I robot devono proteggere la propria esistenza, se questo non entra in conflitto con le prime due leggi». Ora, i tempi sono certamente prematuri per porsi questo genere di problemi: abbiamo infatti a che fare solo con un software e non con agenti in qualche modo autonomi. Tuttavia, è interessante notare che ci stiamo muovendo molto rapidamente nella direzione di una crescente autonomia e "autorevolezza" di questi software, sotto la spinta del mercato, mentre il problema delle limitazioni precauzionali sull’operatività delle macchine non sembra essere di attualità, o quanto meno viene lasciato nelle mani assai poco trasparenti delle aziende produttrici.

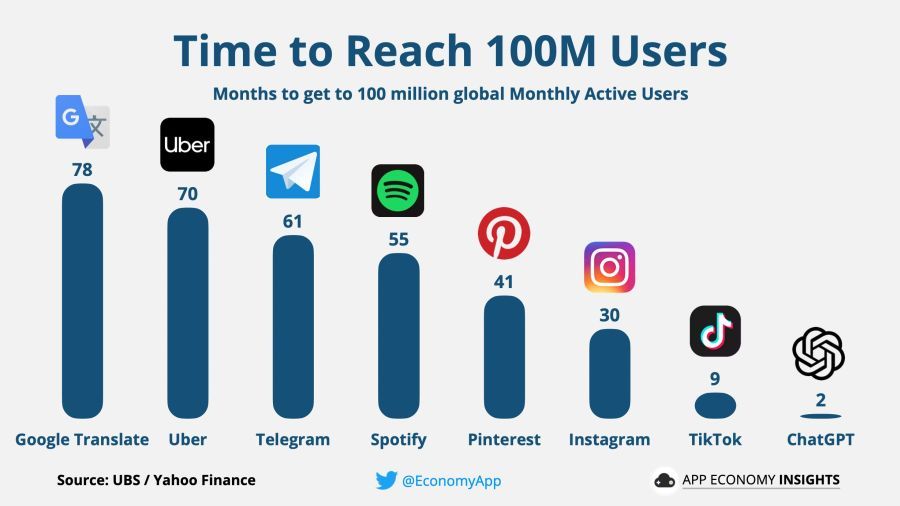

La diffusione dei chatbot basati su LLM sembra già un fenomeno sostanzialmente inarrestabile, sostenuto dalle regole della competizione sul mercato: Google ha già resa pubblica la sua versione del giocattolo (Bard), e certamente Meta e Amazon non tarderanno. Una diffusione capillare dei chatbot sotto forma di app nei nostri telefoni cellulari sembra una prospettiva acquisita. Le possibili conseguenze economiche, sociali e psicologiche sono oggetto di ampio dibattito, ma nella sostanza, restano imprevedibili. E sottolineo: non stiamo parlando qui di una fantascientifica "rivoluzione delle macchine", o di altri scenari apocalittici. Molto più concretamente, ci chiediamo come ci adatteremo, individualmente e socialmente, a questi nuovi strumenti. Quali tipi di lavoro vedranno una possibile sostituzione degli operatori umani con questi tipi di software? Quali saranno gli impatti sulla creatività umana, sulla proprietà intellettuale, sulla credibilità delle notizie? Come ci adatteremo psicologicamente a questi nuovi "partner" informatici, e con quali conseguenze sulla rete delle nostre relazioni sociali?

Siamo insomma di fronte a un (altro) immenso esperimento sociologico, nel quale ci stiamo lanciando senza regole che non siano quelle del mercato. Anche se i chatbot sono, come abbiamo detto, solo macchine, ovvero raffinati software, converrà allacciarsi le cinture di sicurezza.

© Riproduzione riservata