Il momento è particolare: c’è la massima attenzione per il tema dell’intelligenza artificiale (IA) e si registrano passi avanti importanti nella comprensione dei meccanismi del cervello anche grazie a quanto sappiamo del funzionamento delle reti neurali artificiali, su cui si basa l’IA di ultima generazione.

Il momento è anche ad alto rischio, perché i passi avanti sono dovuti in gran parte a grandi conglomerati di potere economico,[1] le cosiddette big tech, che si disputano la primogenitura del progresso a colpi di molti miliardi di dollari, spingendo il mercato azionario verso una bolla assai rischiosa.

Questo appunto argomenta la possibilità di una azione europea, costruttiva invece che soltanto regolamentare,[2] per la concentrazione di capacità di ricerca con finalità open nel campo dell’IA e del cervello, adottando una impostazione simile a quella del CERN.

Il CERN nasce da una convezione tra stati, inizialmente 12 e ora 23 più alcuni osservatori, anche extraeuropei. La finalità è quella della ricerca nella fisica delle particelle; le ricadute dirette e indirette, anche collegate alla costruzione dei macchinari, sono state tantissime. La più nota è la nascita del linguaggio HTML e del protocollo HTTP, con il rilascio open nel 1993. Più recente (2019) il progetto[3] Microservice Architecture on Libre Technology (MALT) per il controllo aperto delle tecnologie informatiche.

Intelligenza artificiale e cervello, oppure neuroscienze, ma con “cervello” si indica un obiettivo più diretto. Non per caso una delle flaghship[4] della ricerca europea (2010) ebbe il nome di Human brain project.[5] Quel progetto, terminato nel 2023 dopo i 10 anni previsti di vita, ebbe inizialmente seri problemi di organizzazione e guida scientifica,[6] poi in gran parte risolti. Una struttura organizzativa mutuata dall’esperienza CERN può essere la strada che consente lo sviluppo di una iniziativa di ricerca di dimensioni ben superiori, includendo l’enorme orizzonte dell’IA. Per inciso: il costo del modello CERN è dell’ordine di un miliardo di euro all’anno.

IA e cervello

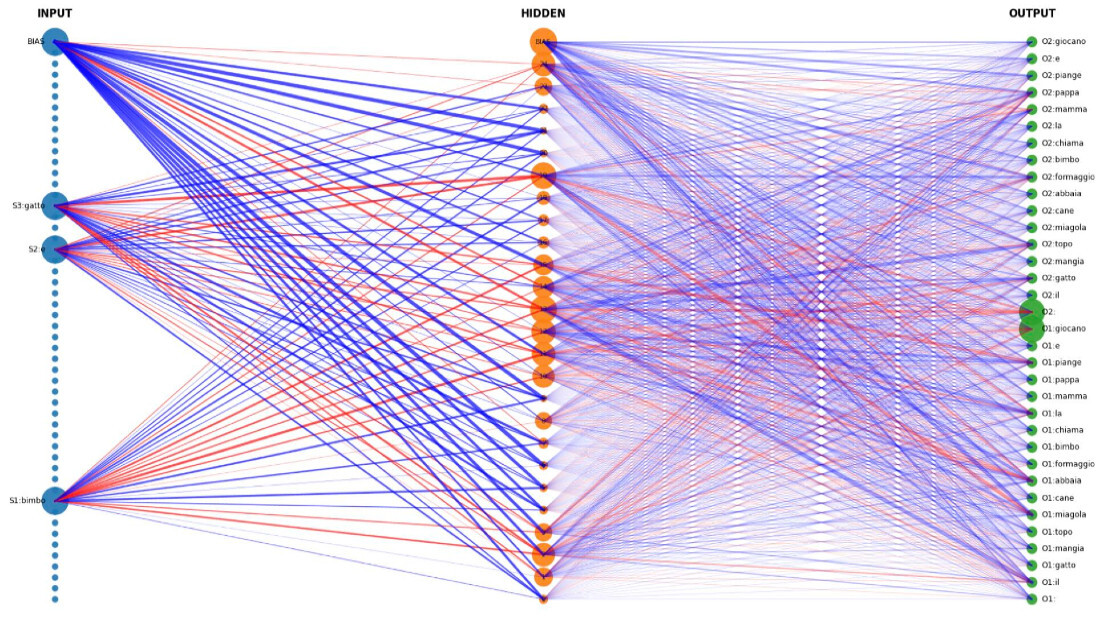

Il collegamento IA-cervello è certamente un moltiplicatore di conoscenze nella ricerca.[7] Nella lunga storia dell’IA, che possiamo far iniziare nel 1956 con il convegno in cui per la prima volta si parla di intelligenza artificiale, il dominio assoluto è stato quello dei sistemi basati su regole, con strutture di complessità assai variabile. Annotiamo che già prima del 1956, nei primi anni ’50, erano comparsi programmi capaci di forme di ragionamento, ad esempio nella prova di teoremi. Negli stessi anni facevano i primi passi le reti neurali artificiali, la cui linea di ricerca si arrestò piuttosto prematuramente a seguito delle critiche espresse da Minsky e Papert (1969). Paradossalmente, quella linea di ricerca diventerà successivamente quella vincente, al di là dei distinguo e delle critiche di principio. Lo diventerà perché funziona e affonda le sue radici in un binomio fondamentale: da un lato, la conoscenza, sia pur limitatissima, del cervello; dall’altro, l’estensione del calcolo statistico a forme non lineari di inferenza.

LeCun et al. (2015) offre una review dello stato dell’arte a poco meno di 10 anni fa; vediamo che le tecniche di deep learning, fondate sulle reti neurali artificiali, hanno preso il sopravvento nella ricerca sull’IA e nelle relative applicazioni, con la rivincita sui denigratori: sia quelli dell’IA in generale, sia quelli delle reti neurali in particolare.[8]

Tra gli autori dell’articolo del 2015 troviamo Geoffrey Hinton, studioso straordinariamente importante, autore con David Rumelhart and Ronald J. Williams di un lavoro – ora citatissimo – che nel 1986 rese popolare l’algoritmo della retropropagazione (backpropagation) dell’errore per il calcolo dei pesi o parametri delle reti neurali multistrato (Rumelhart et al., 1986).

Poi il gran salto, con gli LLMs (Large Language Models) e il lancio di ChatGPT a fine novembre 2022. Riecco Hinton, in un’intervista a Le Monde:[9]

Pour M. Hinton, il ne fait aucun doute que ChatGPT comprend beaucoup plus que nous ne le prétendons dans les médias. Pourtant, pendant sa phase d’entraînement, ce logiciel était censé apprendre simplement à prédire le prochain mot d’une phrase, et pour l’essentiel à partir d’une quantité gigantesque de textes qu’on lui présente. En tant qu’humains, nous n’avons pas appris la logique, l’arithmétique ni le codage informatique en complétant des textes donnés en exemples, alors pourquoi et comment lui y parvient ? Le mystère est à son comble.

Interessantissima osservazione, che conferma la necessità di studiare insieme cervello e IA. Il tema è stato rilanciato recentemente dall’Economist[10] con “AI scientists are producing new theories of how the brain learns”. Il ragionamento per estratto (notare il principio di autorità implicitamente alla base dell’attenzione che fu rivolta a Crick):

(…) Brains learn by being subtly rewired: some connections between neurons, known as synapses, are strengthened, while others must be weakened.

(…) Dr Hinton popularised a clever mathematical algorithm known as backpropagation to solve this problem in artificial neural networks. But it was long thought to be too unwieldy to have evolved in the human brain. Now, as ais are beginning to look increasingly human-like in their abilities, scientists are questioning whether the brain might do something similar after all.

(…) Neuroscientists have always been sceptical that backpropagation could work in the brain. In 1989, shortly after Dr Hinton and his colleagues showed that the algorithm could be used to train layered neural networks, Francis Crick, the Nobel laureate who co-discovered the structure of dna, published a takedown of the theory in the journal Nature. Neural networks using the backpropagation algorithm were biologically “unrealistic in almost every respect” he said.

(…) Scientists working at the boundary between neuroscience and AI have also shown that small tweaks to backprop can make it more brain- friendly. One influential study showed that the mirror-image network once thought necessary does not have to be an exact replica of the original for learning to take place (albeit more slowly for big networks). This makes it less implausible. Others have found ways of bypassing a mirror network altogether. If artificial neural networks can be given biologically realistic features, such as specialised neurons that can integrate activity and error signals in different parts of the cell, then backprop can occur with a single set of neurons.

(…) Other researchers are exploring rather different theories. In a paper published in Nature Neuroscience earlier this year, Yuhang Song and colleagues at Oxford University laid out a method that flips backprop on its head. In conventional backprop, error signals lead to adjustments in the synapses, which in turn cause changes in neuronal activity. The Oxford researchers proposed that the network could change the activity in the neurons first, and only then adjust the synapses to fit. They called this prospective configuration.

L’articolo di Song (Song et al. 2022) è stato richiamato in una recente nota dell’Università di Oxford[11] con il commento:

In artificial neural networks, an external algorithm tries to modify synaptic connections in order to reduce error, whereas the researchers propose that the human brain first settles the activity of neurons into an optimal balanced configuration before adjusting synaptic connections. The researchers posit that this is in fact an efficient feature of the way that human brains learn. This is because it reduces interference by preserving existing knowledge, which in turn speeds up learning.

Una annotazione: mentre siamo sempre più vicini a capire i meccanismi del cervello, la definizione di intelligenza di un computer diventa sempre più difficile da trattare (Mitchell, 2024).

IA e economia

Osserviamo la questione dell’IA con la chiave dell’economia. Il Governatore Panetta, in un recente intervento[12] – che è stato commentato soprattutto per il riferimento al debito pubblico, vicino alla barriera simbolica dei 3mila miliardi –, ha introdotto con grande autorevolezza e peso il tema dell’IA. A pag. 5 e 6:

Anche con più occupazione e più lavoratori stranieri, il contributo del lavoro alla crescita sarà però contenuto. Solo una maggiore produttività – cioè un incremento del prodotto per ora lavorata – potrà assicurare sviluppo e redditi elevati.

Tuttavia, in Europa la produttività cresce lentamente: negli ultimi due decenni abbiamo accumulato un ritardo di 20 punti percentuali rispetto agli Stati Uniti, principalmente a causa della difficoltà che le imprese europee incontrano nell’utilizzare nuove tecnologie nel processo produttivo.

Secondo studi recenti, questa debolezza riflette la frammentazione delle attività di ricerca e sviluppo e la scarsa integrazione tra il mondo scientifico e quello delle imprese. L’industria europea è intrappolata in settori a tecnologia intermedia e poco presente in quelli alla frontiera, nonostante l’eccellenza della ricerca condotta nei singoli paesi.

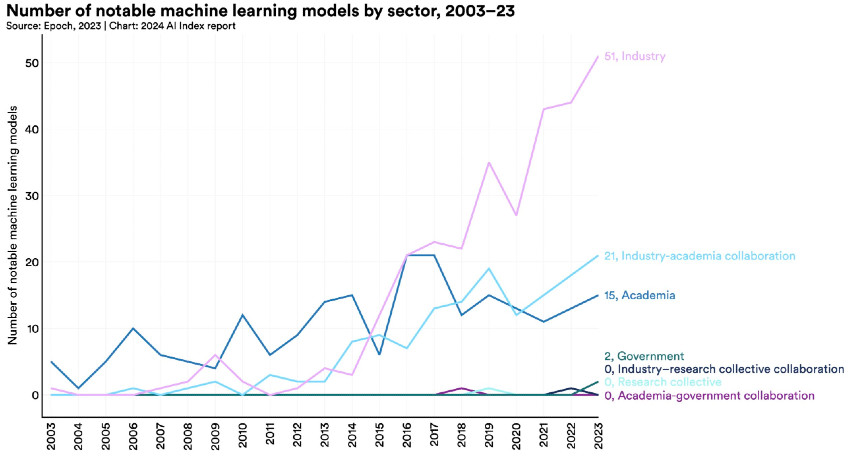

Il caso dell’intelligenza artificiale (IA) è emblematico. Sebbene in questo campo le università europee producano ricerca di qualità, le aziende continentali hanno una presenza trascurabile nello sviluppo della tecnologia: tra il 2013 e il 2023, gli investimenti privati nel campo dell’IA sono stati 20 miliardi di dollari in Europa, contro 330 negli Stati Uniti e 100 in Cina.[13]

È evidente, per motivi sia economici sia strategici, che l’Europa non può limitarsi a essere un semplice utilizzatore della tecnologia. Deve ambire a un ruolo attivo nella sua produzione.

Una presenza significativa dell’Europa in questo settore – oggi dominato da pochi giganti tecnologici globali – accrescerebbe la concorrenza e determinerebbe benefici che oltrepassano la dimensione produttiva e riguardano i diritti essenziali dei cittadini, quali la tutela dei dati personali e il pluralismo nel settore dell’informazione.

Rafforzare l’Europa – e con essa l’Italia – non è solo una necessità economica, ma anche il modo per affermare la nostra sovranità strategica e i nostri valori fondamentali.

Il motore per rendere possibile un cambiamento di passo dell’Europa non può essere né un insieme di finanziamenti alla ricerca secondo i normali canali, pur importanti per mobilitare sforzi transdisciplinari e internazionali, né la concessione di finanziamenti alla produzione, pur apprezzabili per superare lo scoglio degli ostacoli iniziali nei settori più innovativi. Deve essere invece quello della concentrazione delle competenze, secondo il modello del CERN citato, esempio reale e vincente.

Il CERN ha mobilitato i settori più innovativi dell’industria europea per la realizzazione delle sue strutture tecnologiche. Un CERN-IA avrebbe la capacità di mobilitare l’industria dell’elettronica europea in campi altamente competitivi, al di là della guerra dei chip in corso nel mondo.[14] Nel confronto diretto con America e Cina, non c’è gara; operando invece a valle di risultati altamente innovativi su IA e cervello, tutto potrebbe essere possibile.

L’impostazione ricerco-centrica potrebbe anche essere immune dagli hype della finanza e dalle pericolose bolle di Wall Street. Potrebbe e dovrebbe anche affrontare gli aspetti del cambiamento della società con le nuove tecnologie in arrivo; si veda, per un riferimento non convenzionale, Acemoglu e Johnson (2024). Significativo l’abstract:

David Ricardo initially believed machinery would help workers but revised his opinion, likely based on the impact of automation in the textile industry. Despite cotton textiles becoming one of the largest sectors in the British economy, real wages for cotton weavers did not rise for decades. As E.P. Thompson emphasized, automation forced workers into unhealthy factories with close surveillance and little autonomy. Automation can increase wages, but only when accompanied by new tasks that raise the marginal productivity of labor and/or when there is sufficient additional hiring in complementary sectors. Wages are unlikely to rise when workers cannot push for their share of productivity growth. Today, artificial intelligence may boost average productivity, but it also may replace many workers while degrading job quality for those who remain employed. As in Ricardo’s time, the impact of automation on workers today is more complex than an automatic linkage from higher productivity to better wages.

L'unica cosa ne non si può fare, di fronte al cambiamento in rapidissima evoluzione, è accettare l’inerzia.[15]

Documento Draghi

Terminata questa nota, è stato finalmente pubblicato il documento Draghi.[16] A p.85 della seconda parte leggiamo la proposta:

Coordination of key AI verticals at the EU level via a dedicated ‘CERN-like AI incubator’. In the absence of EU hyperscale companies, developing AI verticals requires strong coordination between multiple actors, including AI developers, Research and Technology Organisations (RTOs), and industrial players.

Un riferimento importantissimo su cui riflettere.

[1] Per un sorriso: https://www.gocomics.com/nonsequitur/2024/08/19

[2] https://eur-lex.europa.eu/legal-content/IT/TXT/PDF/?uri=OJ:L_202401689

[3] https://home.cern/news/news/computing/migrating-open-source-technologies

[4] L’iniziativa, varata dell’Europa nel 2010 comprendeva numerosi campi di ricerca, tra cui lo Human Brain Project, https://digital-strategy.ec.europa.eu/en/activities/flagships

[5] https://www.humanbrainproject.eu/en/

[6] https://www.scientificamerican.com/article/why-the-human-brain-project-went-wrong-and-how-to-fix-it/

[7] Un recente articolo sull’Economist offre una ricostruzione molto interessante e aggiornata: AI scientists are producing new theories of how the brain learns, https://www.economist.com/science-and-technology/2024/08/14/ai-scientists-are-producing-new-theories-of-how-the-brain-learns

[8] Il punto di svolta è maturato recentemente, ma già all’inizio del nuovo secolo, un pioniere come Oliviero Stock [https://magazine.fbk.eu/it/spotlight/oliviero-stock/], già direttore dell’ITC-irst di Trento e ora senior fellow dell’FBK-irst, concludeva una relazione sulle prospettive dell’intelligenza artificiale con un bellissimo witz, dal sapore profetico:

Un ebreo (non molto osservante) ha acquistato un pappagallo, bruttino e costosissimo, perché il venditore lo assicura che la bestiola può cantare le preghiere meglio del chazan della sinagoga. Per Rosh-HaShana, il Capodanno ebraico, lo porta dunque in sinagoga, nascosto sotto la giacca, poi comunica ai presenti che il pappagallo canterà; nessuno ci crede, si scommette, il pappagallo si rifiuta tenacemente di cantare e il protagonista del racconto perde molto denaro.

Ritornando a casa comincia a picchiare il pappagallo chiamandolo schmuck (idiota). Il pappagallo allora gli dice: “Schmuck sei tu, tra nove giorni è Yom Kippur, fai di nuovo le scommesse e vedrai quanti soldi ci facciamo".

[Devo alla cortesia di Oliviero Stock il contenuto del witz, che ricordavo con minore precisione.]

[9] Hugues Bersini, Intelligence artificielle : « ChatGPT comprend beaucoup plus que nous le prétendons », Le Monde, 26 décembre 2023, https://www.lemonde.fr/article-offert/itnuxmhecirl-6207747/intelligence-artificielle-chatgpt-comprend-beaucoup-plus-que-nous-le-pretendons

[10] https://www.economist.com/science-and-technology/2024/08/14/ai-scientists-are-producing-new-theories-of-how-the-brain-learns

[11] https://www.ox.ac.uk/news/2024-01-03-new-research-shows-way-brain-learns-different-and-better-way-artificial-intelligence

[12] https://www.bancaditalia.it/pubblicazioni/interventi-governatore/integov2024/PANETTA_21.08.2024.pdf

[13] Qui Panetta cita N. Maslej et al., Artificial Intelligence Index Report 2024, AI Index Steering Committee, Institute for Human-Centered AI, Stanford University, Stanford, aprile 2024, https://aiindex.stanford.edu/report/

[14] https://www.economist.com/schools-brief/2024/07/30/the-race-is-on-to-control-the-global-supply-chain-for-ai-chips

[15] https://www.economist.com/china/2024/08/25/is-xi-jinping-an-ai-doomer, dall’Economist del 25 agosto 2024, Is Xi Jinping an AI doomer?

[16] Prima parte: https://commission.europa.eu/document/download/97e481fd-2dc3-412d-be4c-f152a8232961_en?filename=The%20future%20of%20European%20competitiveness%20_%20A%20competitiveness%20strategy%20for%20Europe.pdf

Seconda parte: https://commission.europa.eu/document/download/ec1409c1-d4b4-4882-8bdd-3519f86bbb92_en?filename=The%20future%20of%20European%20competitiveness_%20In-depth%20analysis%20and%20recommendations_0.pdf

Bibliografia

Acemoglu D., and Johnson S. (2024). Learning From Ricardo and Thompson: Machinery and Labor in the Early Industrial Revolution and in the Age of Artificial Intelligenc. Annual Review of Economics, 16:597–621. ISSN 1941-1391. doi: https://doi.org/10.1146/annurev-economics-091823-025129. https://www.annualreviews.org/content/journals/10.1146/annurev-economics-091823-025129.

LeCun Y., Bengio Y., and Hinton G. (2015). Deep learning. Nature, 521(7553):436–444.

Minsky M., and Papert S. (1969). Perceptrons. MIT Press, Cambridge, MA.

Mitchell M. (2024). The Turing Test and our shifting conceptions of intelligence. Science, 385(6710):eadq9356. doi: 10.1126/science.adq9356. https://www.science.org/doi/abs/10.1126/science.adq9356.

Rumelhart D. E., Hinton G. E., and Williams R. J. (1986). Learning internal representations by error propagation. In David E. Rumelhart and James L. McClelland, editors, Parallel Distributed Processing: Explorations in the Microstructures of Cognition, volume I, chapter 8, pages 318–362. MIT Press, Cambridge, MA.

Song Y., Millidge B., Salvatori T., Lukasiewicz T., Xu Z., and Bogacz R. (2022). Inferring neural activity before plasticity: A foundation for learning beyond backpropagation. bioRxiv. doi: 10.1101/2022.05.17.492325. https://www.biorxiv.org/content/early/2022/10/12/2022.05.17.492325.

Fonte immagine copertina: imagoeconomica.it

© Riproduzione riservata