Il dibattito sul regolamento europeo sull’intelligenza artificiale è entrato nella fase più calda e decisiva, quella del trilogo, cioè il negoziato interistituzionale informale che riunisce rappresentanti del Parlamento europeo, del Consiglio dell’Unione europea e della Commissione europea con l’obiettivo raggiungere un accordo provvisorio su una proposta legislativa. Il primo incontro è avvenuto a giugno, il secondo in luglio. E sembra che la Presidenza spagnola del Consiglio voglia raggiungere un'intesa entro la fine dell'anno.

Tra i temi critici individuati dalla nuova presidenza del Consiglio figura la cosiddetta "valutazione di impatto sui diritti fondamentali". Proviamo a capire innanzitutto di che cosa si tratti e perché sia importante, per poi indagare quali siano le posizioni degli attori in gioco, senza entrare nel merito della proposta di legge sull’IA nella sua interezza.

Valutazione d’impatto sui diritti fondamentali: che cos’è

Al fine di garantire efficacemente la tutela dei diritti fondamentali (si fa riferimento qui alla c.d. "Carta di Nizza" del 2000, diritto primario dell’UE), il Parlamento europeo ha introdotto nella sua posizione finale sul testo della legge sull’IA un articolo – il 29a, inerente appunto alla valutazione dell’impatto sui diritti fondamentali per i sistemi di intelligenza artificiale ad alto rischio.

Occorre sottolineare preliminarmente che l’obbligo in questione è rivolto agli operatori di tali sistemi ad alto rischio (c.d. deployers) ma non anche ai fornitori/produttori (c.d. providers), che pure hanno altri e diversi obblighi. La valutazione d’impatto, da effettuare prima di mettere in uso il sistema di IA, non può prescindere dal contesto di utilizzo del sistema di IA ad alto rischio preso in indagine.

Inoltre, questo processo deve tenere conto di diversi elementi, inclusi inter alia: una descrizione dello scopo previsto del sistema di IA; le categorie di persone e gruppi che potrebbero essere interessati dall’uso del sistema; l’impatto ragionevolmente prevedibile sui diritti fondamentali degli individui, nonché sull’ambiente; un piano dettagliato che descriva le misure o gli strumenti che contribuiranno a mitigare i rischi identificati. In particolare, in mancanza di quest’ultimo, l’operatore deve astenersi dal mettere in uso il sistema di IA ad alto rischio, informando il fornitore nonché l’autorità nazionale di vigilanza senza indebito ritardo.

L’importanza dello strumento

Che l’IA porti con sé rischi in termini di violazioni di diritti fondamentali (ad es., privacy e protezione dei dati, ma anche dignità della persona e integrità della vita, divieto di qualsiasi forma di discriminazione, etc.) è fattuale,. Il sensazionalismo mediatico provocato da ChatGPT ha portato un dibattito fino a quel momento relegato a fora scientifici e specialistici all’attenzione del grande pubblico.

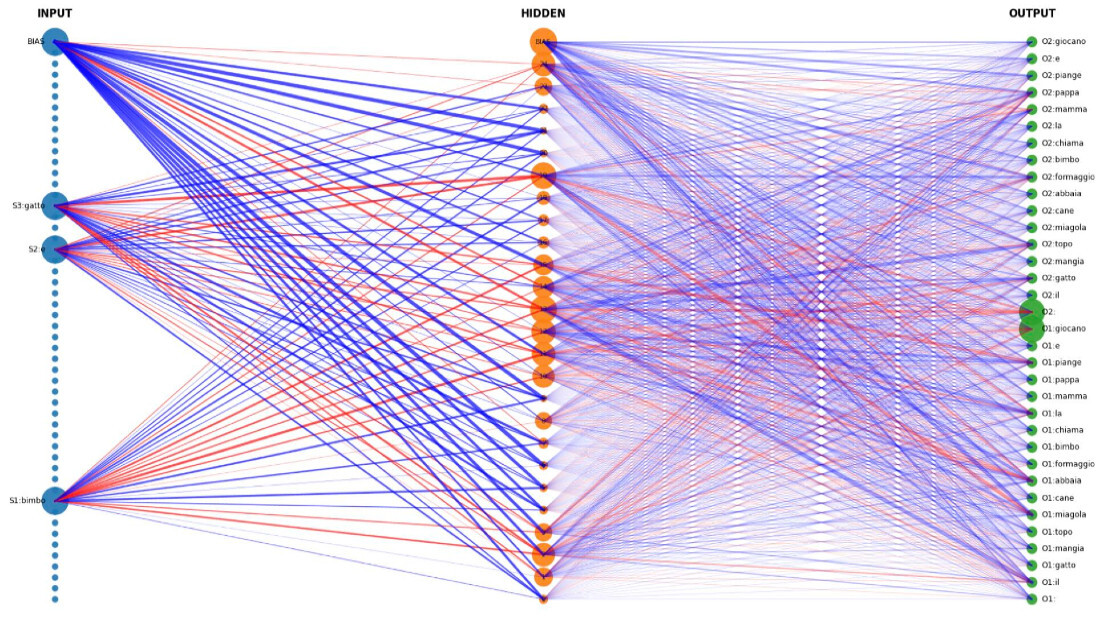

Questi rischi possono risultare non solo da come i sistemi di IA sono progettati, ma anche – e soprattutto, alla luce delle "capacità di apprendimento" di taluni sistemi – dalla successiva fase di utilizzo. È per questo motivo che gli operatori sono stati considerati dal Parlamento i soggetti posti nella posizione migliore per identificare, in primo luogo, e quindi valutare i potenziali rischi posti dal sistema nel caso concreto. Infatti, questa valutazione impone necessariamente un’analisi qualitativa dei singoli diritti fondamentali che si ritengano essere potenzialmente impattati dal sistema di IA analizzato.

Lo strumento della valutazione di impatto non rappresenta una novità assoluta nel panorama della governance di matrice comunitaria del digitale. Infatti, il modello di riferimento del co-legislatore europeo è stato l’articolo 35 del GDPR recante l’obbligo di condurre una valutazione di impatto sulla protezione dei dati (data protection impact assessment, DPIA). Non a caso, infatti, la valutazione di impatto sui diritti fondamentali introdotta nel testo della legge sull’IA deve essere condotta in maniera congiunta con la DPIA, essendo la seconda particolare rispetto alla valutazione generale della prima, la quale verte su tutto il catalogo dei diritti fondamentali, e non ‘solamente’ sul diritto fondamentale alla protezione dei dati (Art. 8 Carta dei diritti fondamentali dell’UE).

Impatti per gli operatori: metodologie per una corretta compliance

Per quanto l’Art. 29a elenchi alcuni elementi minimi essenziali della valutazione d’impatto, la norma è inevitabilmente di alto livello. In altre parole, è onere degli operatori economici cui l’obbligo si riferisce applicare modelli e metodologie appropriate al fine di conformarsi al requisito normativo di carattere generale, secondo uno schema tipico della regolamentazione basata sul rischio.

Tuttavia, sulla scorta dell’esperienza delle DPIA nella materia della protezione dei dati personali, si rileva l’urgenza di metodologie flessibili che consentano agli operatori del mercato di modulare i diversi passaggi della valutazione d’impatto sul caso concreto analizzando impatti specifici a singoli diritti. Schemi rigidi e di ampia portata, costituiti magari in forma di questionari da compilare, possono forse fornire un apparente stato di compliance che però in concreto elude il senso ultimo della norma.

Al riguardo, il futuro “Ufficio per l’IA europeo”, unitamente alle varie autorità nazionali e al mondo della ricerca, dovrebbe elaborare delle metodologie adeguate che illustrino soprattutto come quantificare il rischio posto da tali sistemi agli intangibili diritti e liberà fondamentali. Evidentemente, un simile esercizio richiede una conoscenza approfondita non solo del sistema di IA e del suo campo di applicazione ma anche del catalogo dei diritti fondamentali di riferimento (unitamente alla più recente giurisprudenza sui singoli diritti). Ne consegue che i team di esperti che dovranno occuparsi di tali valutazioni dovranno necessariamente essere multidisciplinari.

Le sfide all’orizzonte

In tale contesto, il Consiglio dell’Unione europea, in preparazione al primo trilogo con il Parlamento circa la legge sull’IA, ha inserito tra gli articoli “critici” – sui quali, cioè, si cercherà un accordo politico durante gli incontri successivi, la previsione di cui all’articolo 29a sulla valutazione d’impatto sui diritti fondamentali.

Allo stato attuale sembra che la presidenza spagnola del Consiglio ritenga l’inclusione di questo obbligo necessaria per raggiungere un accordo. Allo stesso tempo, il Consiglio potrebbe proporre una limitazione dell’ambito di applicazione ai soli enti pubblici, rendendo la consultazione delle parti interessate volontaria anziché obbligatoria.

Un tale scenario, tuttavia, rappresenterebbe un passo indietro nella tutela dei diritti e delle libertà fondamentali nell’era digitale.

© Riproduzione riservata