Sono possibili molte letture dell’accordo europeo sull’IA. Non ci sentiamo né di applaudirlo né di negarne l’utilità. Quanto meno, le istituzioni europee hanno dimostrato una sensibilità sul tema. In ogni caso, un accordo politico non è ancora una legge europea, e noi auspichiamo che prima che diventi legge qualcosa si possa modificare.

Chissà perché occuparsi degli algoritmi solo quando integrano l’intelligenza artificiale. Sono gli effetti degli algoritmi che possono essere spiacenti, non la loro natura che tutto sommato si assomiglia.

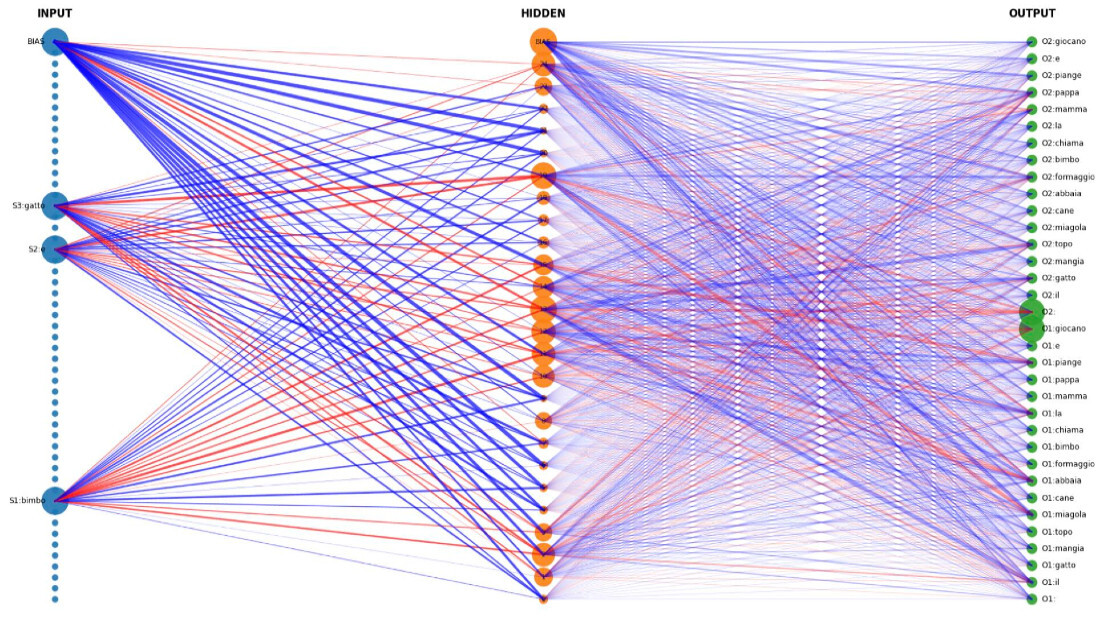

Alcuni hanno vissuto il momento della regolamentazione esultando per il controllo preventivo dagli abusi degli algoritmi. Gli algoritmi però già ci circondano da un bel un po’. Desta sorpresa che a essere regolati siano gli algoritmi di IA, e non quelli meno intelligenti. Anche se appartenenti a generazioni passate, concettualmente gli algoritmi standard e le IA sono delle funzioni che proiettano su un dominio dei risultati il dominio dei dati in input. Sono macchine i primi e sono macchine i secondi.

Noi crediamo che le norme non dovrebbero riguardare o restringere le macchine inferenziali, che si distinguono semplicemente perché sono in grado di apprendere, ossia di regolare i propri parametri secondo i dati, ma potrebbero limitarsi a:

- restringere l’uso di dati non pubblici e non appropriati, proteggendo quelli privati;

- sanzionare non tanto la costruzione di algoritmi, quanto l’uso di algoritmi quando il risultato finale leda diritti come quello all’informazione, alla riservatezza dei propri dati e delle proprie opinioni.

In altri termini, sarebbe stato sufficiente qualche aggiustamento delle norme già esistenti, anziché istituire un codice nuovo per fattispecie tirate per i capelli.

Giusto autorizzare gli usi per scopi di sicurezza, ma il costo per la libertà non è zero. E va bilanciato.

Ci sono pezzi del nuovo articolato che ci convincono un po’ di più. Per esempio, siamo senz’altro d’accordo a riservare alcune applicazioni – tipicamente il riconoscimento biometrico – a casi specifici di prevenzione e persecuzione di reati gravissimi, che vanno dal terrorismo all’omicidio. In questi casi, il fine giustifica i mezzi (nel senso che per raggiungere certi scopi occorre procurarsi mezzi proporzionati, non qualsiasi mezzo), anche se a ben vedere i mezzi da mettere in campo ci fanno pagare due costi: il primo è il costo della perdita di un pezzettino di libertà; il secondo è il costo di dover sopportare i rischi di errore.

Partiamo dal costo degli errori.

Già, perché anche se gli errori non sono esplicitamente citati, qualsiasi algoritmo di classificazione fa errori, che si chiamano falsi positivi, e anche falsi negativi. Nella ricerca di un potenziale terrorista in un ambiente aeroportuale è appropriato un sistema che minimizzi i falsi negativi, anche se questo causa una sovrabbondanza di falsi positivi. È una vecchia regola della statistica alla quale nemmeno le intelligenze artificiali scampano. Anzi, è probabile che gli errori ci siano eccome, visto che i birbanti che desidereranno nascondersi esisteranno e adotteranno strategie per ingannare le videocamere intelligenti, favorendo proprio l’emergere di falsi positivi, ognuno dei quali purtroppo pagherà un costo.

E atterriamo sui costi per la libertà.

Comunque sia, sarebbe bene saperlo: se siamo d’accordo a usare l’intelligenza artificiale per ridurre certi rischi di sicurezza, soprattutto di questi tempi di risveglio del terrorismo internazionale, ci saranno dei costi che pagheremo e un pezzettino della nostra libertà se ne sarà andato per sempre. Per esempio la libertà di intraprendere un viaggio in gran segreto, senza voler far nulla di male, non ci sarà più. Il gioco vale la candela? Sono in molti a pensare che evitare atti di terrorismo sia più importante che garantire viaggi anonimi, e in effetti il sacrificio non è poi molto se pensiamo che per qualsiasi cosa intraprende ognuno di noi lascia una scia di tracce identificabili. Da qualche parte nel mondo c’è traccia di tutti i nostri pagamenti e anche di tutte le nostre geolocalizzazioni.

Semmai, il dubbio su questa prerogativa dei sistemi di IA volti a tutelare la sicurezza è un altro, da un punto di vista liberale.

Fino a che ad usarli sono i rappresentanti di istituzioni di uno stato democratico, tutto bene, perché le istituzioni democratiche sono soggette ai limiti noti come check and balances che sono preposti ad evitare gli abusi. Ma le macchine sono macchine, e quelle intelligenti rispondono ai propri padroni esattamente come quelle stupide. Se le istituzioni cadessero, o piuttosto scivolassero, in mano a poteri autoritari, le intelligenze artificiali che ci scrutano ci impedirebbero piuttosto efficacemente di ribellarci all’autorità, privandoci di un diritto fondamentale che ciascuno noi ha: quello di ribellarsi al tiranno. Ora, si dirà che l’Unione europea è retta democraticamente e che essa sceglie i suoi membri solo se danno garanzie di democrazia e di stato di diritto.

È vero, ma è altrettanto vero che dentro l’Unione europea si sono verificati casi di leader di paesi simpatizzanti per sistemi autoritari. E nella storia degli ultimi cinquanta anni si sono avuti casi di democrazie scivolate nelle democrature. Dunque, le osservazioni che abbiamo fatto non sarebbero trascurabili e suggeriscono che i sistemi cui affideremo il compito di scrutarci per motivi di sicurezza non dovrebbero poi essere tanto diffusi. Andrà trovato un punto di equilibrio, per il momento non così visibile nelle possibili regole di Bruxelles, tra ciò che è utile oggi e ciò che potrebbe essere pericoloso per la libertà domani. I danni di oggi vanno minimizzati non a qualsiasi costo della libertà di domani. Come fare? È un capitolo aperto e che vorremmo che non si chiudesse ancora a seguito del fragile articolato di Bruxelles.

L’obbligo di conformità.

Ci risiamo, quando Bruxelles scrive un testo o una norma, poi pone il vincolo di conformità. E tutto si complica per chi deve lavorare nel settore appena normato. Con l’IA ci siamo ricaduti. Siamo in procinto di obbligare i produttori dei sistemi di IA ad alto rischio a garantire ex-ante la compliance normativa, quindi sostanzialmente la non lesività di tutti gli articoli della norma di uso delle IA. Qui dobbiamo essere chiari, è evidente che il legislatore europeo ha scarsa dimestichezza con gli algoritmi. E non solo con quelli di IA. L’obbligo di verifica preventiva di conformità si estenderebbe anche ai fornitori e alle terze parti partecipanti alla realizzazione dei sistemi.

Ma gli algoritmi non sono monoliti e si compongono di parti che si montano e si assemblano a partire da componenti standard che sono sostanzialmente gli stessi indipendentemente dalla funzione finale dell’algoritmo in cui sono montati.

Facciamo un esempio. Il produttore del pignone dello sterzo di un trattore agricolo potrebbe produrre lo stesso pignone per un’autoblindo armato destinato al campo di battaglia. Chi può certificare che il pignone sia innocuo? Allo stesso modo un sistema di interpretazione della visione notturna può guidare un drone che porta mezzi di salvataggio in una situazione di emergenza catastrofica, come per aiutare una popolazione colpita da un terremoto, come può guidare un drone a commettere un attacco armato. In casi come questi, la certificazione è inutile o impossibile.

Facciamo un altro esempio: sono vietati gli usi dell’IA per assistere sistemi di confusione del voto o di manipolazione dei fatti nelle notizie giornalistiche. Ci parrebbe una buona intenzione, ma siamo sicuri che il controllo preventivo funzioni? Chi volesse progettare e addestrare IA per questo scopo (ed è già stato fatto) semplicemente non si sottometterebbe ai controlli. O qualcuno crede che gli hacker userebbero solo sistemi certificati innocui, non vi pare? E del resto, quale sia il mezzo utilizzato, il punto è che manipolare le elezioni o manipolare le informazioni è o dovrebbe essere un reato, quale sia lo strumento utilizzato. Il passa-parola delle informazioni non è mica vietato nella vita quotidiana. Se le informazioni passate sono lesive di qualcuno, però c’è la calunnia.

Si può forse certificare un sistema di comunicazione che impedisca il passa parola delle calunnie? Secondo me no, invece secondo il legislatore europeo sì, e forse qui ha esagerato. Forse, e dico forse, sarebbe bastato introdurre nei sistemi giuridici norme volte a punire i sistemi di influenza illegittima nel voto.

Cambridge Analytica dimostra che il problema non è mai l’algoritmo.

Il caso di Cambridge Analytica è stato esemplare. Il suo comportamento diretto a influenzare le elezioni presidenziali americane del 2016 non è stato alla fine oggetto di alcuna procedura penale. La società è stata sciolta nel maggio 2018 per lo scandalo mediatico, ma le sue attività (e gli algoritmi, crediamo) sono stati trasferiti a una nuova società (Emerdata Ltd).

Di fronte alla possibilità di casi di questo genere, il legislatore europeo avrebbe potuto introdurre norme a punizione delle manipolazioni: la procedura, comprensiva di adeguata pena, avrebbe costituito il deterrente. Invece, richiedere che le varie XXX Analytica europee si facciano certificare (da chi?) sistemi di IA, così garantendo che non possano influenzare il voto o diffondere fakes è impossibile e forse perfino inutile. Caso mai, siccome pubblicare o diffondere notizie false e tendenziose è punito a norma dell’art.656 del codice penale (in Italia), si potrebbe inasprire questa fattispecie se integrasse l’uso di IA, se questo uso fosse fatto in larga scala, e ancora più se fosse fatto con lo scopo di deviare il corso di un’elezione e se questo fosse fatto con una organizzazione strutturata.

Si potrebbero punire sia gli artefici che i finanziatori di queste azioni, tanto da ribaltare il giudizio dell’opinione pubblica su di loro e andare contro agli stessi loro interessi. Senza necessità di mettersi a decidere preventivamente se ogni IA messa in campo possa o meno produrre risultati di questo tipo.

Sanzioni così gravi e possibili automatismi non sono convincenti.

C’è ancora un aspetto che ci fa riflettere, ed è quello delle sanzioni da applicare per le violazioni alle norme sulle IA. È una cosa che abbiamo visto già più volte. Una sanzione suppone la contestazione di una violazione, l’accertamento che un certo fatto integra la violazione di una prescrizione, un giudizio di un arbitro super partes, che difende la legge, e quindi la esecuzione. Poiché in questo caso si parla di sanzioni che possono arrivare al 7,5% del fatturato e quindi potenzialmente possono rovinare le imprese siamo contrari che possano essere decise ed applicate da autorità regolatorie e di vigilanza, senza un giudizio di merito, dove il giudice sia un terzo imparziale tra le parti.

Lo sviluppo dell’IA sta galoppando e la semplice sorveglianza di tutto quello che avviene è sostanzialmente fuori del campo di possibilità di qualsiasi nuova agenzia. Sempre che un’agenzia nuova occorra e non basti integrare le funzioni di una qualsiasi delle autorità di controllo che già esistono. E, comunque, ogni qual volta un sistema sanzionatorio procede con misure di polizia e non con giudizi di merito, come liberali ci sentiamo di alzare la bandierina e ricordare a tutti che le libertà si toccano solo con giudizi completi e non con misure precauzionali e provvedimenti di polizia.

Rinunciare a un mercato da 407 miliardi di dollari e lasciarlo agli americani, non è intelligente.

A nessuno dei regolatori europei deve essere venuto in mente che l’IA, piaccia o meno, è una evoluzione dei sistemi di calcolo ed è un progresso scientifico. Non è mai particolarmente interessante e intelligente limitare i progressi sul nascere. Vediamo due pericoli. Il primo è di aver legiferato su fattispecie che potrebbero cambiare a breve per la natura caotica del processo creativo e per la velocità del medesimo. Il secondo è di dissuadere, per il costo di compliance e il rischio di sanzione per la violazione di non compliance, la nascita e lo sviluppo di IA made in Europe.

Il mercato dell’IA sta crescendo a un tasso medio annuo composto del 42% ed entro il 2027 varrà secondo Forbes 407 miliardi di dollari. I maggiori investitori nel mondo sono società come NVIDIA, Google, Microsoft e nessuna di queste è europea. La burocrazia prevista dal testo europeo sull’IA suggerirà agli sviluppatori di localizzarsi ancor più in Asia o negli Stati Uniti, per ridurre tempi di sviluppo, costi di conformità e pesanti rischi sanzionatori. Vale la pena lasciare agli altri il gran piatto di una delle innovazioni più importanti di questo decennio? A nostro avviso, no.

Nota: l’immagine di apertura dell’articolo è stata creata con Image Creator di Bing-AI by Microsoft, con tecnologia DALL.E 3

© Riproduzione riservata