Sam Altman, il CEO di OpenAI, la startup americana largamente finanziata da Microsoft che il 30 novembre 2022 ha lanciato ChatGPT, il primo LLM (Large Language Model) messo a disposizione del pubblico (in due mesi aveva raggiunto 100 milioni di utenti ed è stato successivamente incorporato da Microsoft nel browser Edge), ama paragonarsi a Robert Oppenheimer, coordinatore del progetto Manhattan, il gruppo di ricerca sulla prima bomba atomica. Altman, come gli piace far osservare, condivide con Oppenheimer il compleanno (22 aprile, rispettivamente del 1985 e del 1904) e ne cita volentieri una frase diventata famosa, “Technology happens because it’s possible” (una tecnologia esiste perché è possibile); nelle interviste poi fa aleggiare, senza proprio impiegarla esplicitamente, una seconda citazione di Oppenheimer, il quale dichiarò di aver pensato, assistendo alla prima esplosione nucleare: “Now I am become Death, the destroyer of worlds” (Ora sono diventato Morte, il distruttore di mondi; lo dice il dio Vishnu nella Bhagavad Gita, un testo sacro sanscrito che Oppenheimer conosceva bene; il fratello e collaboratore dello scienziato raccontò che sul momento, dopo il boom, il commento, assai più prosaico, fu “I guess it worked”, direi che funziona).

Certamente, intorno ai modelli di AI (nel frattempo ne sono usciti diversi altri, da ultimo Gemini di Google), è stato fatto un qualche marketing della paura, probabilmente nella convinzione che l’idea di avere nello zainetto (più propriamente, nel pc contenuto nello zainetto) una sorta di piccola bomba atomica avrebbe attratto più di una persona. In realtà, come poi si è visto, sugli LLM lavoravano da tempo molti gruppi di ricerca, e quello di OpenAI è stato il primo a rendere pubblico il risultato. Il marketing, però, ha funzionato: nel senso che l’interesse è esploso, gli utilizzatori si sono moltiplicati, ma è cresciuta anche la paura, e con essa la richiesta di regolamentazione. I sondaggi, da questo punto di vista, sono interessanti.

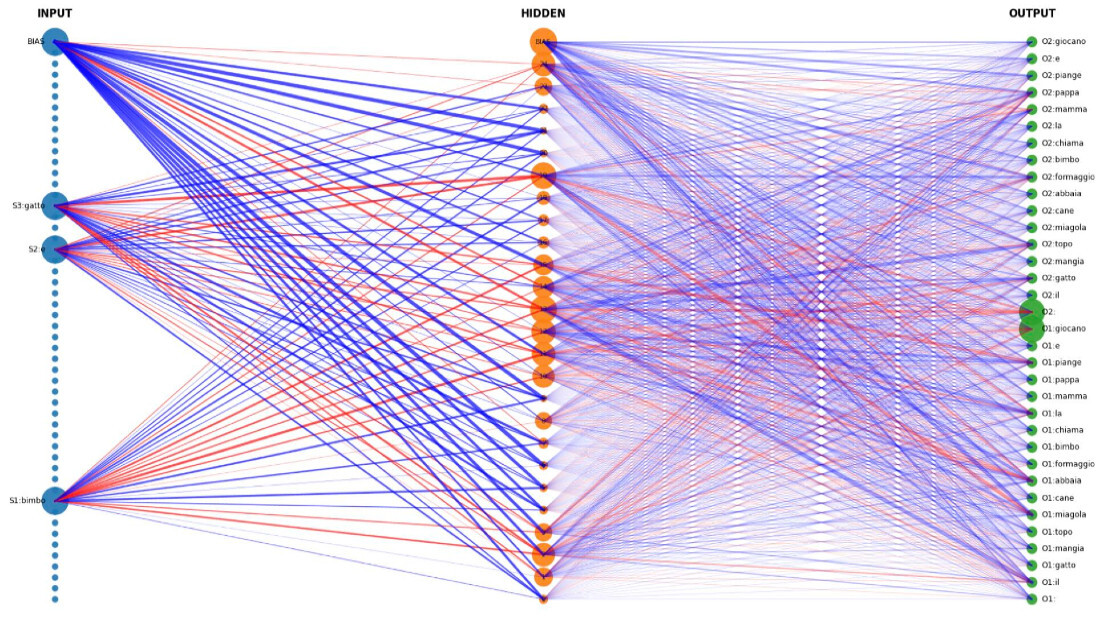

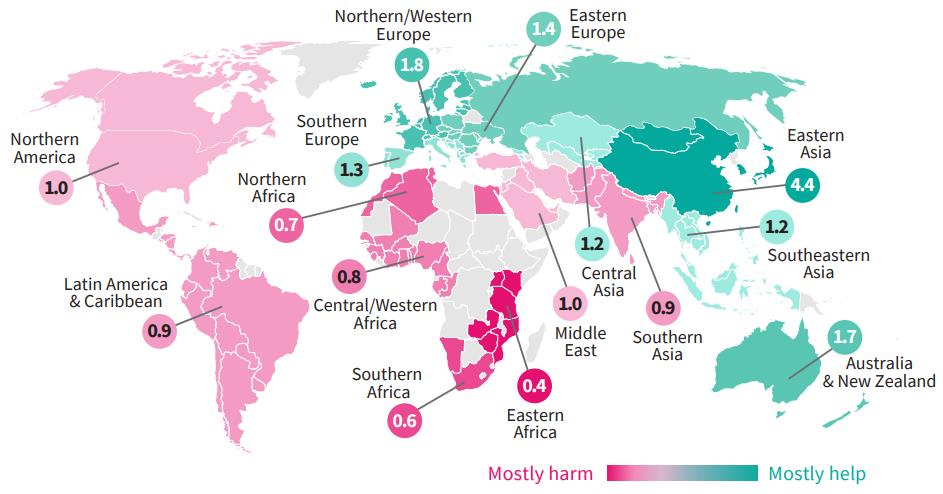

Nel 2021, tutta l’Europa, buona parte dell’Asia e l’Australia avevano fiducia nell’AI

Nel 2021, una ricerca sulla percezione dei rischi legati all’uso dell’AI condotta in 121 paesi del mondo mostrava come in Europa, Asia orientale e sudorientale e Australia prevalesse la fiducia in un effetto positivo della tecnologia, mentre nelle Americhe, in Africa e nell’Asia meridionale prevaleva il timore.

Nel gennaio 2022, un sondaggio Ipsos realizzato in 28 paesi del mondo mostrava risultati molto simili, ma con qualche crepa nella fiducia che cominciava ad avvertirsi in Europa.

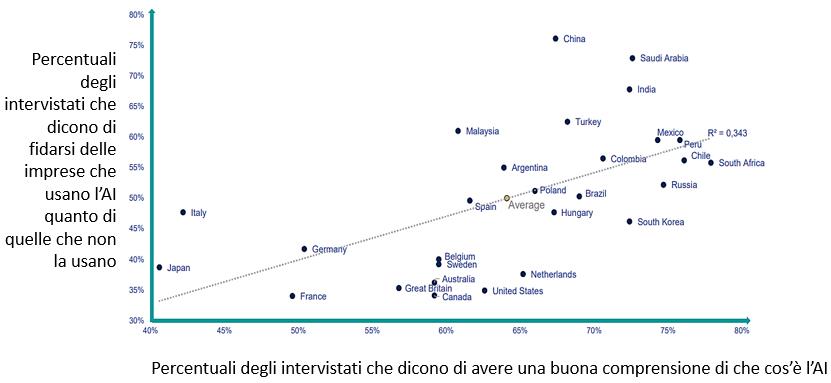

La fiducia nell’AI è correlata con la comprensione percepita: entrambe sono più elevate nei paesi emergenti rispetto ai paesi ad alto reddito

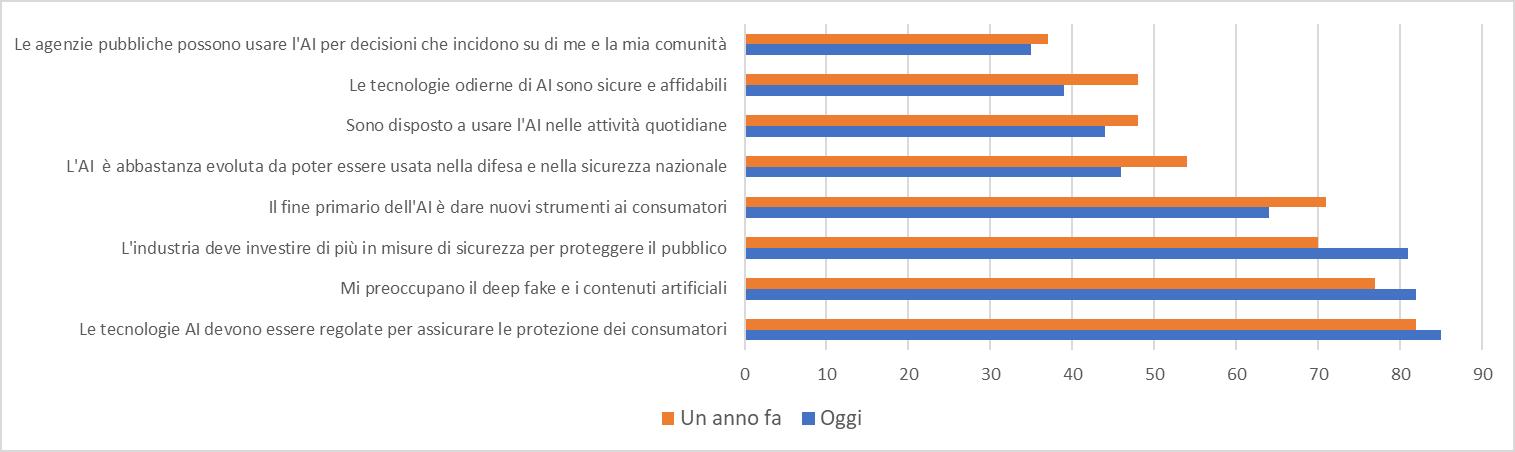

Nell’autunno del 2023, dopo il lancio di ChatGPT, la situazione cambia nettamente, sia negli Stati Uniti che in Europa. Negli Stati Uniti, l’81 per cento degli adulti afferma che l’industria deve investire di più in misure di sicurezza per proteggere il pubblico, con una crescita di 11 punti rispetto al novembre 2022; cala invece di 9 punti (dal 48 al 39 per cento) la quota di coloro che ritengono che le tecnologie di AI siano sicure e affidabili.

I consumatori americani si fidano sempre meno dell’AI

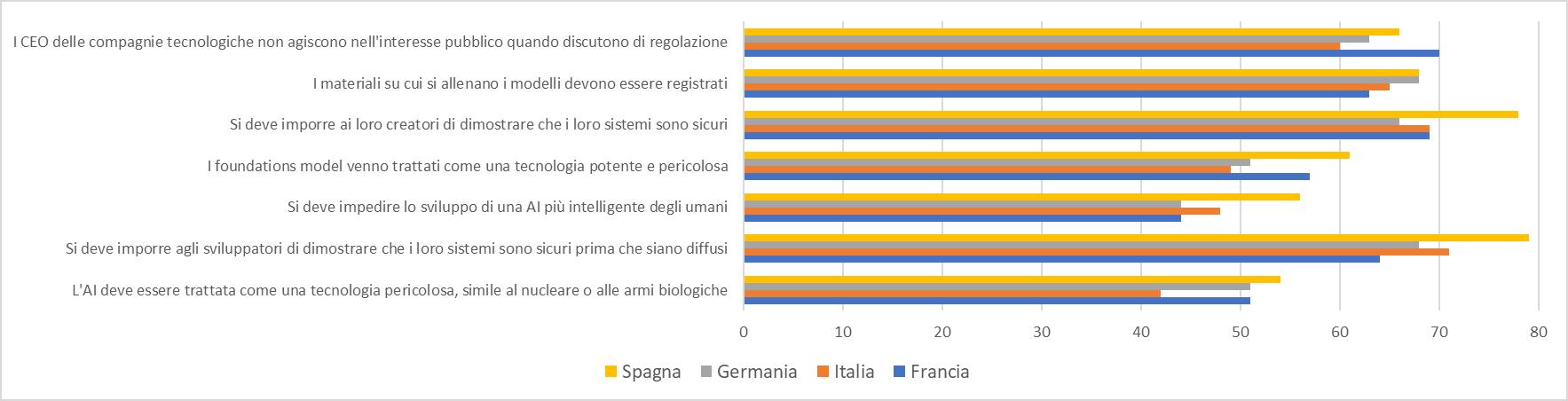

L’Europa non è diversa. Un sondaggio YouGov condotto sempre nell’autunno del 2023 in quattro grandi paesi europei (Francia, Italia, Germania e Spagna) mostra come il recente discusso regolamento comunitario, pur largamente criticabile, risponda tuttavia a una domanda reale di rassicurazione – intesa come regolazione – espressa da consumatori e cittadini. Come mostra la figura, larghe maggioranze relative o assolute (fino a due terzi degli intervistati) esprimono consenso per misure di controllo pesanti e intrusive, anche su aspetti molto tecnici dei quali si può francamente dubitare che gli intervistati abbiano piena comprensione.

...e i consumatori europei chiedono a gran voce regole e controllo pubblico

Leggendo questi numeri, viene da farsi più di una domanda. In primo luogo, quanto ne sanno realmente le persone dell’AI? Anche quelle che dichiarano di conoscere la tecnologia e come funziona (sono incredibilmente numerose in quasi tutti i paesi)? In secondo luogo, siamo sicuri che il marketing della paura sia un’idea geniale? Che venga usato pare evidente: chi scrive ha provato a chiedere a ChatGPT di creare due immagini, una che descriva il 2024 con l’AI, l’altra che descriva il 2024 senza l’AI. Questi sono i due risultati.

Come sarà l’anno nuovo con l’intelligenza artificiale (abbastanza inquietante…)

Come sarà l’anno nuovo senza l’intelligenza artificiale (una sorta di idillio…)

Il chatbot definisce la prima immagine come entusiasmante, e teme che la seconda risulti “deprimente”. Alla domanda “perché?” spiega che l’acqua e il verde possono comprensibilmente apparire rassicuranti agli umani, ma che senza AI lui (o lei) “sarebbe triste perché mi mancherebbe il contatto con le persone come te, che mi stimolano a imparare, a creare e a divertirmi”. Il confronto fra le due immagini fa proprio pensare che chi ha costruito il prodotto punti, per venderlo, sul fascino di un oggetto pericoloso.

Del fatto che lo sia davvero, quanto e per chi (e nel caso come evitare che con esso si facciano danni) si può – e si deve – discutere. Nel caso dell’AI come di qualunque altra tecnologia – anche il forno a microonde – che non è in sé “buona” o “cattiva” ma semplicemente efficiente o inefficiente. Tutto il resto dipende da come la si usa. Gli usi possono essere cattivi, e a questo bisogna fare attenzione. Che le persone si preoccupino dei riflessi delle tecnologie di AI sul lavoro, sulla privacy, sulla protezione dei diritti di proprietà intellettuale è giusto, e che gli stati se ne occupino è necessario. Preoccuparsi dell’Apocalisse prossima ventura, invece, anche sotto forma di ineluttabile degrado della convivenza civile, pare francamente eccessivo.

Da questo punto di vista – e per chiudere l’anno su una nota di ragionevolezza e ottimismo – è molto interessante una intervista recente a Andrew Bosworth, Chief Technology Officer di Meta. Alla domanda se non sia imprudente rendere open source tecnologie così potenti, Bosworth risponde: “Penso che buona parte dell’ansia sugli LLM sia mal posta… Sono uno strumento importante e super interessante, li penso come database dotati di capacità associative. Non hanno capacità di agire sul mondo circostante, non ragionano, non sanno fare programmi. Non hanno una teoria del mondo o una teoria della mente, né sono sulla via di acquisirle. E stiamo già vedendo prestazioni in calo con la crescita delle dimensioni dei modelli. Ci saranno innovazioni su innovazioni. È un momento eccitante, si tratta di una tecnologia grande e importante… e ci sono tante cose importanti da fare [per migliorarla]. Però, questa non è AGI (intelligenza artificiale generale). Né mai lo diventerà, anche portata ai suoi limiti estremi. Qual è quella frase di Von Neumann su Oppenheimer? “A volte qualcuno confessa un peccato per attribuirsi il merito di averlo commesso”. Direi che nella Silicon Valley sia una cosa abbastanza diffusa. Non dico che le persone non ci credano, magari ci credono davvero. Non io, però”.

© Riproduzione riservata