Lo sviluppo e la diffusione dell’AI costringono a ripensare le figure professionali, non tanto e non solo nell’ottica di scongiurare la temuta sostituzione tecnologica, ma anche e soprattutto al fine di consentire, abbracciando una visione meno pessimistica del (prossimo) futuro, una fruttuosa convivenza tra l’uomo e la macchina[1].

L’introduzione della nuova tecnologia apre la strada a inedite ed interessanti opportunità di impiego, derivanti dall’esigenza, di carattere organizzativo e, nel contesto europeo, anche normativo, di inserire in azienda lavoratrici e lavoratori incaricati di supervisionare i processi automatizzati.

Del resto, è proprio sul principio del coinvolgimento umano (human-in-the-loop), se non del controllo umano (human-in-command), che, al netto della retorica, poggia l’antropocentrismo che ispira il Regolamento Europeo sull’Intelligenza Artificiale (Reg. 2024/1689/UE o anche solo “AI Act”) e, in misura ancora più marcata, la Direttiva Piattaforme (Dir. 2024/2831/UE)[2].

Come noto, l’AI Act opera una classificazione dei sistemi di intelligenza artificiale in:

- Sistemi a rischio inaccettabile;

- Sistemi ad alto rischio;

- Sistemi a rischio minimo o nullo.

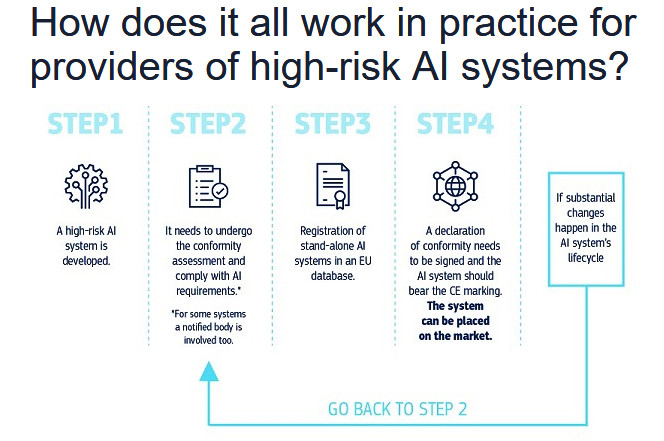

Se l’immissione in commercio e l’utilizzo di un sistema di AI a rischio inaccettabile viene vietata all’interno del territorio europeo[3], tra i sistemi ad alto rischio rientrano, ai sensi dell’art. 6, par. 2, e dell’allegato III dell’AI Act, i software utilizzati, in generale, nel campo dell’occupazione, della gestione dei lavoratori e dell’accesso al lavoro autonomo[4].

L’impiego degli strumenti ad alto rischio non è precluso in radice, ma, nella misura in cui questi presentino un rischio significativo di danno per la salute, per la sicurezza o per i diritti fondamentali (anche non influenzando significativamente il processo decisionale) e, in ogni caso, qualora effettuino una profilazione delle persone fisiche ai sensi del GDPR[5], il loro utilizzo è condizionato al rispetto di una serie obblighi.

In altri termini, l’AI Act ha edificato un impianto di obblighi (a monte) e di responsabilità (a valle) in capo al provider (fornitore dei sistemi di AI) e al deployer (utilizzatore dei sistemi di AI), miranti ad assicurare, nell’ipotesi di ricorso a sistemi ad alto rischio (ovvero, se si eccettuano le ipotesi che ricadono nel divieto ex art. 5 AI Act, nella sostanziale totalità dei casi in cui l’AI può essere utilizzata nella gestione dei rapporti di lavoro), la trasparenza, l’affidabilità ed il controllo da parte dell’essere umano.

Ciò che maggiormente rileva in questa sede è che l’art. 14 AI Act prescrive che tali sistemi ad alto rischio vengano progettati e sviluppati in modo tale da poter essere efficacemente supervisionati da persone fisiche durante il periodo in cui sono in uso (art. 14, par. 1, AI Act).

Segnatamente, l’obbligo di “sorveglianza umana” (human oversight) implica lo svolgimento di una variegata serie di prerogative, che spaziano dalla comprensione delle capacità e dei limiti dei sistemi , al monitoraggio del funzionamento e all’interpretazione dei relativi output, sino alla decisione di ignorare, annullare o ribaltare quest’ultimo o di arrestare il sistema nel caso di grave pericolo per i diritti fondamentali (art. 14, comma 4, AI Act).

Nell’imporre tale obbligo in capo alle imprese che intendano introdurre l’AI nei propri processi “ad alto rischio”, la normativa europea sembra prevedere la creazione dell’inedita figura professionale dello “Human Oversight Officer” (HOO).

Quest’ultimo, stando alla lettera dell’art. 14 dell’AI Act, dovrebbe risultare in possesso di competenze tanto tecniche, quanto organizzative, gestionali e legali: quasi un ircocervo, dunque, che, nelle realtà più strutturate, potrebbe forse prendere la forma di un apposito ufficio (office), più che di una singola persona (officer), per quanto a capo del primo vi dovrà pur sempre essere, come si ricava dal 91° Considerando dell’AI Act, un individuo dotato di competenze trasversali, alfabetizzato sull’AI, formato rispetto alle esigenze aziendali e dotato dei necessari poteri[6].

La figura in esame presenta indubbiamente alcune affinità con il Data Protection Officer (DPO), che trova la propria disciplina negli artt. 37-39 del GDPR ed è ampiamente diffuso nella prassi. Un primo tratto in comune sono le competenze trasversali, per quanto, nel caso del DPO (v. art. 37, par. 5, GDPR), la conoscenza della normativa è incentrata sulla materia dei dati personali, mentre lo HOO deve avere lo sguardo puntato sugli effetti dell’AI sui diritti fondamentali a più ampio raggio. Inoltre, il DPO può essere un dipendente dell’impresa o un soggetto esterno alla stessa (art. 37, par. 6, GDPR), a differenza dello HOO, che, dovendo essere in grado di monitorare costantemente il funzionamento dell’AI, di intervenire sul relativo output e di disporre l’arresto del sistema nei casi di pericolo per i diritti fondamentali, dovrebbe trovare la propria naturale collocazione all’interno dell’impresa ed in una posizione apicale: operando a stretto contatto con il livello più elevato del management (v., relativamente al DPO, l’art. 38, par. 3, AI Act) e occupandosi di una complessa quanto delicata funzione, lo HOO non potrebbe che rientrare nella categoria legale del quadro o, più verosimilmente (specie nelle realtà aziendali più complesse), del dirigente.

Al netto del confronto con il DPO, può essere poi utile verificare se, nella contrattazione collettiva, vi siano figure in qualche modo assimilabili allo HOO.

Quest’ultimo presenta in effetti alcune similitudini con il responsabile della gestione del cambiamento e dell’innovazione inquadrato nel livello A1 del CCNL metalmeccanici. Tale profilo, che pure si inserisce nell’area funzionale delle tecnologie, si caratterizza per l’approccio interdisciplinare, interfunzionale e intersezionale e trova la propria classificazione come quadro. Tuttavia, la figura in esame gode di poteri che appaiono limitati se posti a confronto con le prerogative dello HOO, che ha l’autorità, oltre alla responsabilità, di interpretare gli output dell’AI e di interrompere l’intero processo nel caso di un possibile nocumento per i diritti fondamentali.

Né pare agevole trovare un omologo della figura di cui all’art. 14 dell’AI Act nei profili dalla più elevata professionalità contemplati nel CCNL Telecomunicazioni (TLC): segnatamente, il quadro di VII livello, che accorpa i profili del Big Data Architect o dell’ICT System Architect (ma ad analoghe conclusioni si potrebbe giungere in riferimento al Chief Information Officer di cui al I Livello CCNL Commercio), non deve possedere necessariamente competenze giuridiche e non può di regola spingersi sino a prendere autonomamente la decisione di bloccare i processi, a differenza dello HOO.

In realtà, è proprio l’assenza di una specifica declaratoria contrattual-collettiva dedicata alla figura dello HOO a stimolare una riflessione sull’adeguamento, non solo delle fonti negoziali, ma anche, se non soprattutto, dei profili professionali e delle competenze del personale già in servizio.

D’altro canto, l’art. 4 dell’AI Act, in vigore dal 2 febbraio 2025, pone significativamente in capo, tanto ai fornitori quanto agli utilizzatori dell’AI, un obbligo di literacy (alfabetizzazione) dei propri dipendenti in materia di intelligenza artificiale. La formazione costituisce, infatti, la più solida garanzia contro l’obsolescenza professionale ed il mezzo più efficace di prevenzione della sostituzione dell’uomo con una macchina sempre più “intelligente” e di sviluppo di una fruttuosa convivenza tra uomo e tecnologia[7]. Senonché, il riferimento alla formazione nell’art. 4 AI Act appare tanto opportuno, quanto (inevitabilmente) generico, al punto da rischiare di restare lettera morta in assenza di una precisa perimetrazione dei contenuti dell’obbligo di formazione dei dipendenti ad opera del datore di lavoro.

Di tale compito si è storicamente occupata proprio la contrattazione collettiva, la quale presenta le caratteristiche di duttilità e di adattabilità per natura estranee alla legge. In fondo, a prescindere dalle scarne indicazioni normative (anche all’interno dello stesso AI Act), la via negoziale sembra rappresentare, per un’impresa che intenda cogliere la sfida dell’AI, il volano per una più certa e sicura compliance con le disposizioni dell’AI Act e del diritto nazionale. La contrattazione collettiva, infatti, darebbe una più certa e condivisa veste alle nuove figure professionali come, appunto, lo HOO, oltre a rivelarsi utile nella prospettiva di un’accettazione trasversale dell’impiego della tecnologia nel contesto aziendale e nel processo di adeguamento delle professioni tradizionali alla presenza di un possibile assistente automatizzato.

In tal modo, non solo verrebbe scongiurata la fine del lavoro, ma troverebbero un’adeguata valorizzazione le opportunità occupazionali derivanti dalla trasformazione tecnologica in corso[8].

[1] https://www.italiaoggi.it/diritto-e-fisco/diritto-e-impresa/intelligenza-artificiale-imprese-obbligate-a-riorganizzarsi-uoe9lcki.

[2] Per approfondimenti, v. M. Biasi, Problema e sistema nella regolazione lavoristica dell’intelligenza artificiale: note preliminari, in federalismi, 2024, 30, 162 ss.

[3] Per quanto concerne l’area di interesse lavoristico, l’art. 5 dell’AI Act si riferisce ai sistemi di riconoscimento delle emozioni sul posto di lavoro, ad eccezione di quelli che riconoscono il dolore o la fatica per motivi medici o di sicurezza (art. 5, par. 1, lett. f); non sono inoltre utilizzabili i sistemi di categorizzazione biometrica delle persone volti a dedurre caratteristiche sensibili come la razza, le opinioni politiche, l’affiliazione sindacale, l’orientamento sessuale e il credo religioso (art. 5, par. 1, lett. g).

[4] Più nel dettaglio, si tratta di sistemi di AI destinati a essere utilizzati per l'assunzione o la selezione di persone fisiche, in particolare per pubblicare annunci di lavoro mirati, analizzare o filtrare le candidature e valutare i candidati; sistemi di AI destinati a essere utilizzati per adottare decisioni riguardanti le condizioni dei rapporti di lavoro, la promozione o cessazione dei rapporti contrattuali di lavoro, per assegnare compiti sulla base del comportamento individuale o dei tratti e delle caratteristiche personali o per monitorare e valutare le prestazioni e il comportamento delle persone nell'ambito di tali rapporti di lavoro.

[5] Ci si riferisce ovviamente al Regolamento Generale Europeo per la Protezione dei Dati Personali (Reg. 2016/679/UE).

[6] Si veda anche, nell’ambito del lavoro tramite piattaforma digitale, l’art. 10, par. 2, Dir. 2024/2831/UE, a mente del quale “gli Stati membri impongono alle piattaforme di lavoro digitali di garantire risorse umane sufficienti per supervisionare e valutare in modo efficace l’impatto delle decisioni individuali prese o sostenute dai sistemi di monitoraggio automatizzati o dai sistemi decisionali automatizzati. Le persone incaricate dalla piattaforma di lavoro digitale di svolgere la funzione di supervisione e valutazione dispongono della competenza, della formazione e dell’autorità necessarie per esercitare tale funzione, comprese quelle necessarie per non accogliere le decisioni automatizzate”.

[7] F. Lamberti, Formazione, occupabilità e certificazione delle competenze (tramite blockchain): un’alternativa alla “disoccupazione tecnologica”, in M. Biasi (a cura di), Diritto del lavoro e intelligenza artificiale, Giuffrè, Milano, 2024, p. 281 ss.

[8] V. Dipartimento per la Trasformazione Digitale e Agenzia Italiana per l’Italia Digitale (AGID), Strategia Italiana per l’Intelligenza Artificiale, 2024, 12: “Una strategia che spinge sull’adozione di sistemi di Intelligenza Artificiale accelererà evidentemente il processo di trasformazione….cruciali saranno le iniziative dell’area strategica della formazione, e più nello specifico i percorsi di upskilling e reskilling, prestando grande attenzione a preservare e migliorare la qualità del lavoro a valle dell’adozione di sistemi di IA e del riposizionamento del personale”

© Riproduzione riservata